「手描きのラフを綺麗な線画にしたい」「お気に入りの画像の線画だけ抽出して色塗りの練習に使いたい」

そんな風に思ったことはありませんか?実はStable Diffusionを使えば、一瞬で複雑なイラストから線画だけを抜き出したり、ラフ画を清書したりすることが可能なんです。

特に「ControlNet」という機能を使いこなせれば、プロ顔負けの線画抽出が自由自在になります。今回は、初心者の方でも迷わずできるように、Stable Diffusionで線画を抽出・生成する方法を、優しく丁寧に解説していきますね。

この記事を読むと、以下のことが理解できます

- 既存のイラストや写真から、綺麗な線画だけを抽出する具体的な手順

- 描いたラフ画をAIに清書(クリーンアップ)させる設定方法

- 線画のみを生成するための呪文(プロンプト)とコツ

- 抽出した線画に自動で色を塗る逆パターンのテクニック

Stable Diffusionで線画を抽出・生成する基本テクニック

Stable Diffusionで線画を扱うには、大きく分けて「既存画像から抽出する」方法と、「最初から線画として生成する」方法の2つがあります。

ここでは、最も需要が高いControlNetを使った抽出方法と、プロンプトだけで生成する手軽なテクニックを中心にお話しします。

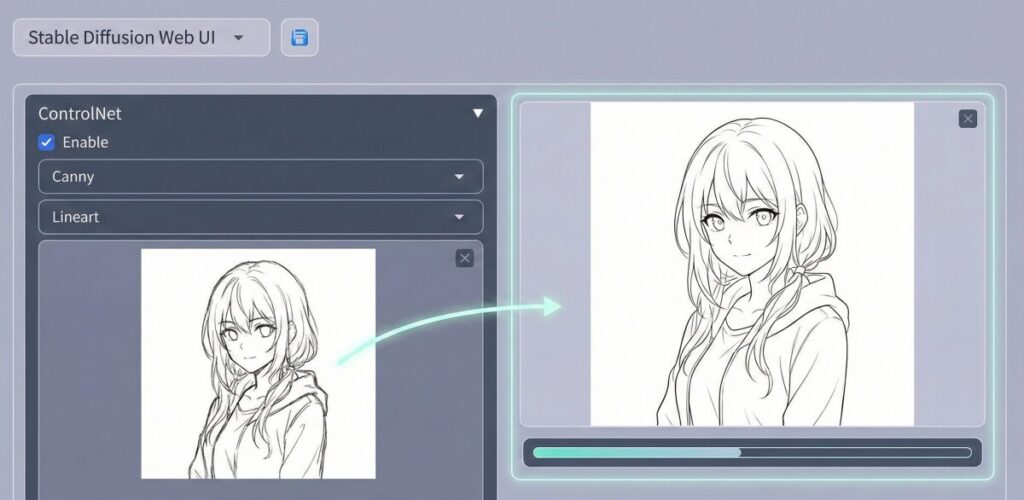

ControlNetでの線画化(Canny/Lineart)

結論から言うと、線画抽出にはControlNet(コントロールネット)という拡張機能が必須です。これを使えば、元画像の特徴を維持したまま、線画データだけを取り出せます。

主なやり方は以下の手順です。

- Stable Diffusionの「txt2img」または「img2img」タブを開く

- 画面下部のControlNetパネルを開く

- 元画像をドラッグ&ドロップする

- 「Enable(有効化)」にチェックを入れる

- プリプロセッサ(Preprocessor)とモデルを選択する

ここで重要になるのが、「どのプリプロセッサを選ぶか」です。以下の表を参考に選んでみてください。

| 種類 | 特徴 | おすすめの用途 |

| Canny | 輪郭をパキッと強く検出する。細かい線まで拾う。 | 背景込みのイラスト、詳細な抽出 |

| Lineart | 手描き風の自然な強弱がある線画になる。 | キャラクターイラスト、アニメ塗り |

| Lineart_anime | アニメイラストに特化した綺麗な線画。 | アニメ調の絵、萌え絵 |

| Softedge | 鉛筆で描いたような柔らかい線画。 | ラフな雰囲気を出したい時 |

Cannyは最強の抽出ツールですが、ノイズまで拾いすぎることがあります。一方、Lineart系はノイズを無視して「線画としてあるべき線」を推測してくれるので、イラスト用途ならLineartがおすすめですよ。

ラフから線画を清書する方法

「自分で描いた下手なラフを、AIに清書させたい!」というのも、よくある悩みですよね。

この場合、img2img(画像から画像を生成)とControlNetを組み合わせるのが鉄板です。

やり方はこうです。

まず、img2imgの入力欄に「自分の描いたラフ画」を入れます。そして、プロンプトには完成形のイメージ(例:1girl, school uniform, masterpiece)を入力します。

ここでポイントなのが、ControlNetの設定です。

ControlNetにも同じラフ画を入れ、プリプロセッサに「Scribble(スクリブル)」または「Lineart」を設定してみてください。

すると、AIはあなたのラフの線を「下書き」として認識し、それをなぞるようにして綺麗な線画を描き直してくれます。

ただ、AIが勝手に描き変えすぎないように、「Denoising strength(ノイズ除去強度)」を0.5〜0.7くらいに調整するのがコツです。数値が低いとラフ画のま残りすぎ、高いと別物になってしまいます。

線画のみをプロンプトで生成するコツ

元画像がなく、ゼロから「塗り絵用の線画」を作りたい場合もありますよね。

そんな時は、プロンプト(呪文)だけで制御できます。

特別なツールは不要で、いつものプロンプトに以下の単語を加えるだけです。

- monochrome(モノクロ)

- greyscale(グレースケール)

- lineart(線画)

- white background(白背景)

- simple background(シンプルな背景)

例えば、こんな風に組み合わせます。

masterpiece, best quality, 1girl, cute, long hair, monochrome, lineart, white background, simple background

逆に、「color(色)」や「shading(影)」をネガティブプロンプトに入れておくと、より綺麗な白黒線画が出やすくなりますよ。

ChatGPTで線画抽出はできる?

「ChatGPTでも線画抽出はできるの?」という疑問を持つ方も多いかもしれません。

これには、少し注意が必要です。

ChatGPT(DALL-E 3)は、アップロードした画像を直接加工して線画だけを抜き出す機能は持っていません(2025年現在)。

あくまで、ChatGPTは「新しい画像を生成する」のが専門です。

しかし、Stable Diffusion用の「線画生成プロンプト」を作らせることは得意です。

例えば、「Stable Diffusionで、複雑なメカ少女の線画を作りたい。そのための英語プロンプトを書いて」とお願いすれば、最適な単語の羅列を作ってくれます。

つまり、ChatGPTは「抽出」ではなく、「生成のための指示役」として使うのが正解ですね。

Stable Diffusionの線画抽出と応用テクニック

基本ができたら、次はもっと自分好みに調整したり、抽出した線画を活用したりする応用編に進みましょう。

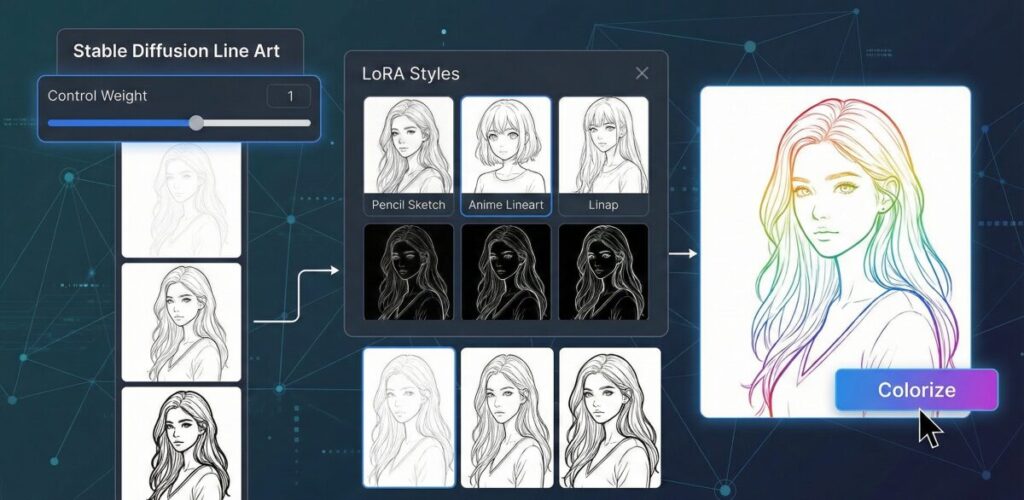

ここでは、LoRAを使ったスタイル変更や、逆に線画に色を塗る方法など、一歩進んだテクニックを紹介します。

線画の強弱を調整するパラメーター

抽出した線画が「細すぎる」とか「主張が強すぎる」と感じることはありませんか?

そんな時は、ControlNet内の「Control Weight(コントロールの重み)」をいじってみてください。

- Weight 1.0(デフォルト): AIへの指示と元画像の線画をバランスよく反映します。

- Weight 1.5以上: 元画像の線の形をガチガチに守ります。線が太く濃くなりやすいです。

- Weight 0.5以下: 線画の形を少し無視して、AIのアレンジが加わります。線が弱く、ふんわりします。

また、Cannyを使う場合は「Threshold(閾値)」という設定も重要です。数値を下げると細かい線まで拾い、上げると主要な輪郭線だけが残ります。

プレビュー(Allow Preview)を見ながら、ちょうどいい塩梅を探るのが一番の近道ですね。

LoRAを使って好みの線画スタイルにする

プロンプトだけではどうしても「AIっぽい線」になってしまう…。

そんな悩みがあるなら、LoRA(追加学習モデル)の出番です。

世界中の有志が、特定の画風を再現するLoRAを配布しています。中には「鉛筆書き風(Pencil Sketch)」や「万年筆風(Ink Style)」、「アニメ原画風」といった、線画に特化したLoRAも存在します。

これらを適用することで、単なる「データとしての線」ではなく、「味わいのある線画」を一発で出せるようになります。

Civitaiなどの配布サイトで「Lineart LoRA」や「Sketch LoRA」と検索してみると、面白いモデルがたくさん見つかりますよ。

抽出した線画への色塗り方法

「線画抽出」の逆パターン、「線画への自動色塗り」もStable Diffusionの大得意分野です。

自分で描いた線画や、先ほど抽出した線画に、一瞬で着彩できます。

手順は以下の通りです。

- txt2imgを開く(img2imgでも可)。

- 色を塗りたい「線画」をControlNetにアップロードする。

- Control Typeで「Lineart」や「Canny」を選ぶ。

- プロンプトに「塗りたい色や雰囲気」を入力する(例:blue hair, golden eyes, sunset lighting)。

- 生成ボタンを押す!

これだけで、線画の枠からはみ出さずに、プロンプト通りの色を塗ってくれます。

もし、色が線画を無視して塗られてしまう場合は、ControlNetのモデルが正しく設定されているか確認しましょう。白背景に黒い線の画像なら、「Invert Input Color(色反転)」が必要な場合もあります(プリプロセッサによっては自動でやってくれます)。

実務で使えるレベルを目指すなら

ここまで、Stable Diffusionでの線画テクニックを紹介してきました。

趣味で楽しむ分には、これらを知っているだけで十分すごい作品が作れます。

ただ、もしあなたが「これを仕事にしたい」「副業でイラスト案件を受けたい」と考えているなら、もう一歩踏み込んだスキルが必要です。

クライアントワークでは、「なんとなく良い絵」ではなく、「クライアントの指示通りの完璧な線画」や「修正可能なレイヤー分け」などが求められるからです。

独学でそこまで極めるのは、正直かなり時間がかかります。エラーが出た時に解決策がわからず、挫折してしまう人も少なくありません。

そこでおすすめなのが、「バイテック生成AIスクール」です。

このスクールは、単にツールの使い方を教えるだけでなく、「どうやって実務で稼ぐか」に特化しています。

今回紹介したようなControlNetの高度な制御はもちろん、企業レベルの高品質な画像生成や、実際にクラウドソーシングで案件を獲得するためのサポートまで行ってくれます。

趣味の範囲を超えて、生成AIを「武器」にしたいと考えているなら、一度チェックしてみると良いかもしれませんね。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

まとめ

最後に、Stable Diffusionでの線画抽出について要点をまとめました。

- 線画抽出にはControlNetという拡張機能が必須である

- パキッとした線なら「Canny」、自然な線なら「Lineart」を選ぶ

- ラフ画の清書にはimg2imgとControlNetを併用する

- プロンプトのみで生成するなら「monochrome」「lineart」を入れる

- 背景を白くしたい場合は「white background」を指定する

- ChatGPTは画像の抽出はできないがプロンプト作成には役立つ

- 線の強弱はControl Weightで調整が可能である

- Cannyの閾値を調整すると線の密度が変わる

- 手描き風の質感を出したいなら専用のLoRAを活用する

- 抽出した線画に色を塗るのもControlNetで簡単にできる

- 色塗りの際は線画をControlNetに入れてプロンプトで色を指定する

- AIによる清書時はノイズ除去強度(Denoising strength)がカギ

- 線画抽出はイラストの練習や塗り絵作成にも最適である

- 実務レベルのスキル習得には専門スクールも選択肢の一つ

- まずはプレビュー機能を使って設定値を試行錯誤するのが近道

参考資料・出典

- Stable Diffusion 開発元公式情報

- 画像生成AIの基礎技術およびモデルのライセンスや仕様については、開発元であるStability AIの公式発表に基づいています。

- 出典:Stability AI Japan 公式サイト

- ControlNet 技術論文(arXiv)

- 記事内で解説した「ControlNet」の構造や線画抽出のアルゴリズム(Canny, Lineart等)に関する技術的な詳細は、原著論文を参照しています。

- 出典:Adding Conditional Control to Text-to-Image Diffusion Models (arXiv:2302.05543)

- AIと著作権に関する公的な見解

- 生成AIを利用した画像の権利関係や法令遵守の指針については、文化庁が公表している資料に準拠しています。

- 出典:文化庁著作権課「AIと著作権」

.jpg)