「せっかく最高に可愛いキャラクターが生成できたのに、服装だけがイメージと違う!」なんて経験、あなたにもありませんか?顔やポーズは完璧なのに、服を変えるためだけに再度生成し直すと、今度は顔が変わってしまう……これは画像生成AIを始めたばかりの人が必ずぶつかる壁ですよね。

でも、安心してください。Stable Diffusionには、お気に入りのキャラクターの顔や構図をそのまま残して、服装だけを自由自在に変えるテクニックが存在します。これさえ覚えれば、ファッション雑誌のように次々と衣装チェンジを楽しんだり、同じキャラクターで様々なシチュエーションの画像を生成したりすることが可能になります。

この記事では、初心者の方でも迷わず操作できるように、基本的な機能である「Inpaint」の使い方から、少し応用的な「LoRA」や「ControlNet」を使った着せ替え術まで、優しく噛み砕いて解説していきます。専門用語ばかりで難しそうに見える設定も、一つひとつ理由がわかれば決して怖くありません。一緒に、あなたの作ったキャラクターの可能性を広げていきましょう!

この記事を読むと、Stable Diffusionで服装だけ変えることについて、以下の4点が理解できます。

- Inpaint機能を使って、画像の特定部分(服装)だけを修正する具体的な手順

- プロンプトや設定数値を調整して、服の色やデザインを思い通りに変えるコツ

- LoRAやControlNetを活用して、特定の衣装を綺麗に着せる応用テクニック

- 生成画像のクオリティを上げ、実務レベルでも通用するスキルを身につける方法

Stable Diffusionで服装だけ変える基本のアプローチ

まず最初に、最も基本的かつ多くのユーザーが利用している方法から見ていきましょう。Stable Diffusionには標準で「Inpaint(インペイント)」という機能が備わっています。これは、画像の一部をマスク(黒塗り)して、その部分だけをAIに再描画させる機能です。

この機能を使えば、顔や背景はそのままに、服装だけを指定して書き換えることができます。特別な拡張機能をインストールしなくても、WebUI(Automatic1111など)さえあればすぐに試せるのが大きな魅力です。ここでは、その具体的な設定やコツについて深掘りしていきましょう。

Inpaintモデルと設定の基礎

「Inpaint」を行う際、実はとても大切なポイントがあります。それは、通常モデルではなくInpaint専用のモデルを使うことです。

多くのモデルファイルには、通常版とは別に「inpainting」と名の付くバージョン(例:sd-v1-5-inpainting.ckptなど)が用意されています。通常のモデルでもInpaintは可能ですが、どうしても修正した部分と元の画像の境目が不自然になりがちです。一方、Inpaint専用モデルは、周囲の画像との馴染ませ方を学習しているため、まるで最初からその服を着ていたかのような自然な仕上がりになります。

操作手順の基本は以下の通りです。

- WebUIの「img2img」タブを開き、その中の「Inpaint」タブを選択します。

- 服装を変えたい画像をアップロードします。

- ブラシツールを使って、変えたい「服の部分」を塗りつぶします(マスクを作成)。

- プロンプト欄に、新しく着せたい服の指示(例:

blue hoodieなど)を入力します。

ここで重要になるのが「Denoising strength(ノイズ除去強度)」という設定値です。この数値は「元の画像をどれくらい無視して書き換えるか」を決めるパラメータです。

- 0.7 〜 1.0: 元の服の形を無視して、全く新しいデザインの服に変えたい場合。

- 0.4 〜 0.6: 元の服の形やシワをある程度維持しつつ、変更を加えたい場合。

服装をガラッと変えたいときは、思い切って数値を0.7以上に設定してみましょう。ただ、あまり高くしすぎると背景との整合性が取れなくなることもあるので、何度か試行錯誤が必要です。

部分的に服の色だけ変えるテクニック

「デザインや形は気に入っているけれど、服の色だけ変えることはできないかな?」と思うこともありますよね。例えば、白いドレスを赤いドレスに変えたいといった場合です。

この場合もInpaint機能を使いますが、設定のコツが少し異なります。形を変えずに色だけを変えるためには、先ほど説明した「Denoising strength」を低め(0.3 〜 0.5程度)に設定するのがポイントです。

数値が低いと、AIは元の画像(元の服のシワや陰影)を強く参考にして描画します。その上でプロンプトに (red dress:1.2) のように色を強調して指定すると、服の質感やドレープ感はそのままに、色味だけを変更することができるのです。

また、ControlNetという機能が使える環境であれば、さらに精度を高められます。「ControlNet Canny」や「Lineart」といった機能を使えば、元の画像の線画情報を抽出して固定できるため、服の輪郭を完全に保ったまま色塗りだけを変えるような芸当も可能です。

以下の表に、目的別の推奨設定をまとめましたので参考にしてください。

| 目的 | 推奨 Denoising strength | プロンプトのコツ | 備考 |

| 服を全く別に変える | 0.7 〜 0.9 | 新しい服の特徴を詳細に記述 | 元の服より大きく塗りつぶすのがコツ |

| 色だけを変える | 0.3 〜 0.5 | 色を強調 (red:1.3) など | 元の陰影が残るので自然に見える |

| 柄や素材を変える | 0.5 〜 0.6 | 素材名 denim, silk を指定 | ControlNetとの併用がおすすめ |

服装をランダムに変えて楽しむ

ここまでは「着せたい服が決まっている」場合の話しでしたが、逆に「どんな服が似合うか分からないから、AIに提案してほしい」という場面もあるでしょう。そんな時は、服装をランダムに変更するテクニックが役立ちます。

これには「Dynamic Prompts」という拡張機能を使うのが一般的です。これを使うと、プロンプトの中に {white shirt|black dress|kimono} のように複数の選択肢を記述でき、生成するたびにAIがそこからランダムに一つを選んで描画してくれます。

例えば、以下のようなプロンプトをInpaint時に入力します。

1girl, {school uniform|maid costume|casual clothes}, cute, smile

こうして「Batch count(生成枚数)」を増やして一度に数枚生成すれば、同じポーズ・同じ顔で、制服姿、メイド服、私服といった異なるバリエーションを一気に作ることができます。

「自分では思いつかなかったけれど、このキャラには意外とこの服が似合う!」という新しい発見があるのが、ランダム生成の醍醐味です。ガチャを回すような感覚で楽しめるので、デザインのアイデア出しにも最適ですね。

アニメ調イラストでの服装固定のコツ

さて、アニメ調のイラストで服装を変更する際、特有の難しさがあることにお気づきでしょうか?実写系に比べて、アニメ調のイラストは線がはっきりしているため、マスクの境界線が少しでもずれると「塗り残し」や「線の途切れ」が目立ってしまいます。

これを防ぐためのテクニックとして「Mask blur(マスクのぼかし)」の設定が重要です。アニメ塗りの場合、この数値をあまり大きくしすぎると境界が滲んで汚くなることがあります。通常は4〜8程度がデフォルトですが、アニメ調の場合は少し下げて調整してみると良いでしょう。

また、服装固定、つまり「特定のキャラクターのいつもの衣装」を維持したまま、ポーズや背景だけを変えたいという逆のパターンもアニメ絵では需要が高いです。

この場合は、Inpaintではなく「ControlNet OpenPose」を使います。

- 着せたい服を着ている画像を生成(または用意)する。

- その画像を

img2imgに入れて、ControlNetでポーズ(棒人間)だけを指定して再生成する。

こうすることで、服のデザインを大きく崩さずに、様々なポーズを取らせることが可能になります。アニメキャラは「キャラクター性=衣装」という側面が強いため、服装を固定する技術は、ファンアートや漫画制作において非常に強力な武器になります。

Stable Diffusionで服装だけ変えるLoRAと応用術

基本のInpaintに慣れてきたら、次はもう少し高度な「着せ替え」に挑戦してみましょう。ここでは、特定の衣装デザインを正確に再現する「LoRA(ローラ)」の活用や、プロンプトだけでは難しい細かな制御を行うための応用テクニックを解説します。

ここまで出来れば、あなたはもう初心者卒業と言っても過言ではありません。自分のイメージ通りの作品を作るための引き出しを、ここで一気に増やしていきましょう。

LoRAを活用して特定の服だけ着せる

Stable Diffusionの世界には「LoRA」と呼ばれる追加学習ファイルがあります。これは、特定のキャラクターや画風、そして服装などをAIに追加で覚え込ませるための小さなファイルです。

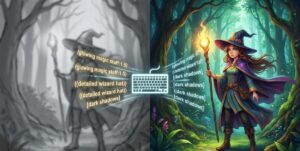

ネット上(Civitaiなどのサイト)には、数多くの「服装LoRA」が公開されています。「魔法少女の衣装」や「特定の制服」、「サイバーパンクなスーツ」など、プロンプトで細かく説明するのが難しい複雑なデザインでも、LoRAを使えば一発で呼び出すことができます。

ただし、LoRAで服だけを変えようとするときに一つ問題が起こりがちです。それは「服装のLoRAを使うと、顔までそのLoRAの影響を受けて変わってしまう」という現象です。

これを防ぐためには、主に2つのアプローチがあります。

- Block Weight(ブロックウェイト)を使う:LoRAの影響範囲を調整するプラグインです。「OUT層(服装や背景など)」にはLoRAを効かせ、「IN層(顔の構造など)」には効かせない、といった設定が可能です。これを使えば、顔は元のモデルのまま、体だけに衣装LoRAを適用できます。

- ADetailer(エーディテイラー)を使う:画像を生成した後、自動的に「顔だけ」を検知して、高画質に修正してくれる拡張機能です。服LoRAの影響で顔が崩れてしまっても、ADetailerが最後に綺麗な顔に書き直してくれるため、結果として「顔は綺麗で服はLoRA指定通り」という画像が出来上がります。

初心者の方には、設定が比較的簡単な「ADetailer」の導入をおすすめします。これを入れるだけで、全身画でも顔が崩れにくくなり、クオリティが格段に上がりますよ。

狙い通りに服の色を変える指定方法

前述のInpaintでも少し触れましたが、プロンプトだけで服の色を変えるテクニックをもう少し深掘りしましょう。

AIは時々、色の指定を間違った場所に適用してしまうことがあります。「赤い服、青い髪」と指定したのに、「青い服、赤い髪」になってしまう……これは「色移り(Color bleeding)」と呼ばれる現象です。

これを防ぎ、狙った服だけに色をつけるには「Cutoff」という拡張機能を使う方法もありますが、プロンプトの書き方を工夫するだけでも改善します。

- BREAK構文を使う:

red dress BREAK blue hairのように、要素の間にBREAKを入れることで、AIに「ここで情報の区切りがあるよ」と教えることができます。 - 括弧で強調する:

(red dress:1.2)のように色とアイテムをセットで強調します。

また、Inpaint中にプロンプトを書く際は、変更したい部分(服)の情報「だけ」を書くのがコツです。例えば、全身画像の服だけをマスクしてInpaintする場合、プロンプトに 1girl, face, hair などの余計な情報を書くと、服の中に小さな顔が生成されてしまう(ホラーですね!)ことがあります。マスク部分には「何を描くべきか」だけを、つまり red dress, high detail といった服に関する情報だけを入力すると成功率が上がります。

失敗しないための画像生成環境作り

ここまで、InpaintやLoRA、ControlNetといった様々な機能を紹介してきました。これらを使いこなせば、まさに自由自在に画像を操れるようになります。

ただ、正直なところ「機能が多すぎて覚えるのが大変」「拡張機能のインストールでエラーが出て進まない」といった壁にぶつかることも多いのではないでしょうか?特にControlNetやIP-Adapterといった高度な機能は、導入手順が複雑で、PCのスペックも要求されます。

もしあなたが、趣味の範囲を超えて「もっと効率的に、思い通りの画像を生成したい」あるいは「このスキルを活かして副業や仕事に繋げたい」と考えているなら、独学で時間を浪費するよりも、体系的に学べる環境に身を置くのも一つの賢い選択肢です。

例えば、「バイテック生成AIスクール」のような専門のスクールでは、Stable Diffusionの高度な制御技術はもちろん、仕事として使えるレベルのクオリティを出すためのノウハウを実践形式で学ぶことができます。

特にバイテックでは、単にツールの使い方を教えるだけでなく、

- 商業レベルのアウトプット: 企業の即戦力となるLP素材や広告バナーの作成

- 案件獲得特化: クラウドソーシング等での実際の仕事の取り方

- ControlNet等の高度な技術: 独学では躓きやすい複雑な設定の完全マスター

といった、「実務活用」に特化したカリキュラムが組まれています。

「服の色を変える」といった個別のテクニックだけでなく、それらを組み合わせて「クライアントの要望通りの画像を作る」スキルは、今後ますます需要が高まっていくでしょう。

もちろん、まずは無料の情報で試行錯誤するのも楽しいプロセスです。しかし、もし「本気でAIクリエイターを目指したい」と思った時は、こうしたプロの環境があることも思い出してみてくださいね。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

まとめ:Stable Diffusionで服装だけ変える重要ポイント

それでは、今回解説した内容をまとめます。Stable Diffusionで服装だけ変えるためには、適切なツールの選択と設定の微調整が鍵となります。

改めて、重要なポイントを整理しました。

- 服装変更の基本はInpaint機能を使うことである

- 自然な仕上がりには「Inpaint専用モデル」の使用が推奨される

- 服の形を変えたい時はDenoising strengthを0.7以上に設定する

- 服の色だけ変えたい時はDenoising strengthを0.3~0.5に抑える

- プロンプトで色を指定する際は強調構文が有効である

- ControlNet Cannyを使えば服のシワや形を維持したまま色変更ができる

- ランダムな服装変更にはDynamic Promptsやワイルドカードを活用する

- アニメ調イラストのInpaintではマスクのぼかし設定に注意する

- ポーズを変えずに服を変えるならInpaint、服を変えずにポーズを変えるならOpenPoseを使う

- 特定の衣装を着せるにはLoRAが便利だが顔への影響に注意が必要だ

- LoRAによる顔崩れはADetailerやBlock Weightで防ぐことができる

- 色移りを防ぐにはBREAK構文などでプロンプトを整理する

- Inpaint時のプロンプトは変更したい要素だけに絞ると失敗が少ない

- 高度な編集技術は実務レベルのスキルとしても需要が高い

- 独学が難しい場合は専門スクールで体系的に学ぶのも近道である

Stable Diffusionの機能は日々進化していますが、今回紹介した「部分的に修正する技術」は、どんなに新しいモデルが出ても変わらず使える普遍的なスキルです。

最初はマスクを塗るのが面倒に感じるかもしれませんが、慣れてしまえば「あ、ここの服だけ直そう」と、まるで魔法のように画像を修正できるようになります。ぜひ、あなたのPCでいろいろな服を着せて、キャラクターの新しい魅力を引き出してみてくださいね!

参考資料・出典

本記事の技術的解説は、以下の一次情報および公式発表に基づいています。

- Stable Diffusionの基盤技術に関する論文

High-Resolution Image Synthesis with Latent Diffusion Models (CVPR 2022)

Stable Diffusionの基礎となる「Latent Diffusion Models」について詳述された、ミュンヘン大学等の研究チームによる原著論文です。 - ControlNetの技術仕様と実証

Adding Conditional Control to Text-to-Image Diffusion Models (ICCV 2023)

本記事で紹介した「姿勢制御」や「輪郭抽出」を可能にするControlNet技術の構造と効果について記述された公式論文です。 - Stable Diffusion 公式開発元

Stability AI Official Website

生成AIモデル「Stable Diffusion」の開発元であるStability AI社の公式サイトおよび公式リリース情報です。

.jpg)