Stable Diffusionを使っていて、「この背景、最高に綺麗!でもキャラクターの表情だけ変えたいな…」って思うこと、よくありますよね。

逆に「キャラは完璧だけど、背景がおかしいから直したい」なんて悩みも尽きないはず。

実は、Stable Diffusionで背景を固定するのは、ただプロンプトを入力するだけでは難しく、生成AIの中でもちょっとしたコツが必要な部分なんです。

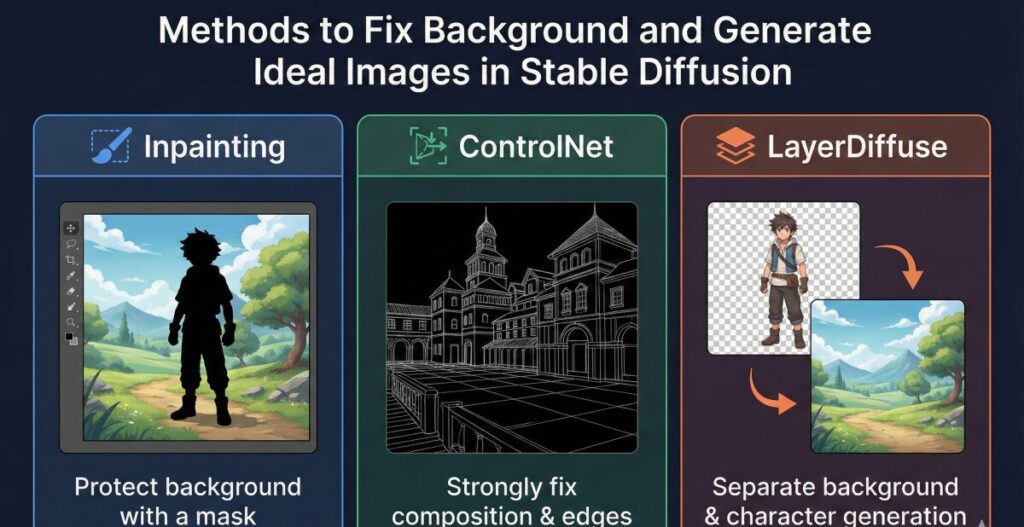

でも、安心してください。InpaintingやControlNet、そして最新のLayerDiffuseなどの機能を使えば、誰でも思い通りの構成で作れるようになりますよ。

この記事では、初心者の方でも迷わないように、背景をコントロールするための具体的な手順を優しく解説していきますね。

ここで紹介するテクニックを身につければ、以下のことができるようになります。

- お気に入りの背景を固定したまま、キャラクターの服装や表情だけを自由に変更できる

- LayerDiffuseなどの最新技術を使って、背景と人物をきれいに合成する方法がわかる

- 背景が崩れたり、背景がおかしい時におこなう具体的な修正アプローチを理解できる

- 背景を指定するプロンプトや、背景生成に強いLoRA・モデルの選び方がわかる

Stable Diffusionで背景を固定して理想の画像を生成する手法

せっかく良い雰囲気の画像ができても、再生成ボタンを押すと背景までガラッと変わってしまう。

これはStable Diffusionの仕組み上、仕方のないことではあるんですが、いくつかの機能を使えば「ここだけ変えないで!」という指示が出せるんです。

ここでは、Stable Diffusionで背景を固定するための代表的なアプローチを4つ紹介します。

Inpaintingで背景を変えない方法

まず一番基本となるのが「Inpainting(インペインティング)」という機能です。

これは、画像の「変えたい部分」だけを塗りつぶして(マスクして)、それ以外の部分を背景を変えないように保護する技術ですね。

例えば、背景はそのままで人物の顔だけ変えたい場合、「Inpaint masked」という設定を使います。

具体的な手順:

- 「img2img」タブにある「Inpaint」を開く

- 変えたくない部分(背景)ではなく、変えたい部分(人物)を黒く塗りつぶす

- 設定で「Inpaint masked」を選ぶ

- 「Original」を選択して生成する

こうすれば、マスクしていない背景部分は一切変更されずに、塗りつぶした人物だけが再生成されます。

ただ、境界線が不自然になることもあるので、「Denoising strength(ノイズ除去強度)」を0.4〜0.6くらいに調整するのがコツですよ。

ControlNetを活用して背景を指定する

もし、もっと厳密に「構図」や「背景の書き込み」を維持したいなら、ControlNetが最強のツールになります。

特に「ControlNet Inpaint」や「Tile」というモデルを使うと、元画像の情報を強く残したまま生成ができるんです。

おすすめの設定:

- ControlNet Inpaint: マスクした部分以外を強力に固定します。通常のInpaintよりも背景の維持力が高いです。

- ControlNet Tile: 画像全体の解像感を上げつつ、背景の細かな書き込みを維持してくれます。

これを使えば、「背景の建物の形はそのままに、質感だけリアルにする」といった高度なStable Diffusion 背景 指定が可能になります。

多くのプロが愛用している方法なので、ぜひ試してみてくださいね。

LayerDiffuseで背景と人物を分離

最近注目されているのが、「LayerDiffuse」という技術です。

これは、最初から「背景が透明な人物画像」と「人物がいない背景画像」を別々に生成できる画期的な拡張機能なんです。

LayerDiffuseのメリット:

- 人物を「透過PNG」として生成できる

- 後からPhotoshopなどでStable Diffusion 背景 合成が簡単にできる

- 背景と人物が溶け合ってしまう(癒着する)失敗がない

これなら、「背景だけ変える」作業も、「人物だけ別の場所に移動させる」作業も自由自在ですよね。

従来の生成方法とは少し違いますが、これが出来れば素材作りの幅が一気に広がります。

便利な拡張機能や背景LoRAおすすめ

もちろん、プロンプトやモデル(Checkpoints)の力も借りましょう。

背景を描くのが苦手なモデルを使っていると、いくら頑張ってもStable Diffusion 背景 おかしい状態から抜け出せません。

背景に強いアプローチ:

- 背景特化のLoRAを使う: 「Detailed Background」系のLoRAを入れると、書き込み量が格段に増えます。Stable Diffusion 背景 LoRA おすすめで検索して、Civitaiなどで探してみましょう。

- 拡張機能「Tiled Diffusion」: 画像を小さく分割して生成することで、背景の細部まで破綻せずに描画できます。

例えば、風景画が得意なモデルに切り替えるだけでも、背景のクオリティは劇的に変わりますよ。

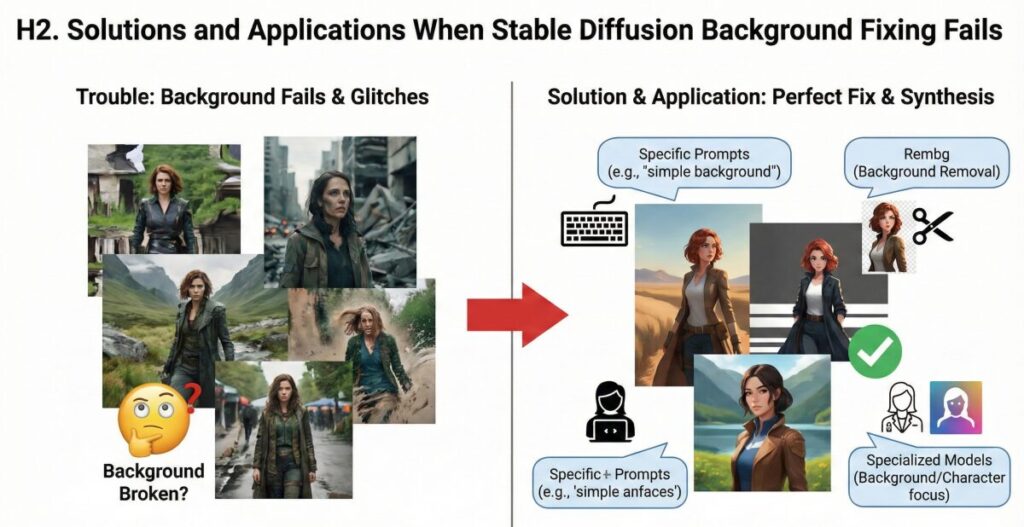

Stable Diffusionで背景固定がうまくいかない時の解決策と応用

「やり方はわかったけど、やっぱりうまくいかない…」

そんな時もあると思います。

特にAIはランダム要素が強いので、100%思い通りにするには試行錯誤が必要です。

ここでは、失敗した時のリカバリー方法や、よりクオリティを上げるための考え方について解説します。

プロンプトで背景指定するコツ

背景が固定できない理由の一つに、「プロンプトが曖昧すぎる」というケースがあります。

AIに迷いを与えないよう、具体的かつ強力なワードを入れることが大切です。

効果的なプロンプト例:

simple background(シンプルな背景):余計なものを描かせたくない時white background(白背景):切り抜き前提の時detailed scenery(詳細な風景):書き込みを増やしたい時

また、ネガティブプロンプトにblurry background(ぼやけた背景)やbad backgroundを入れるのも効果的です。

プロンプトでしっかりStable Diffusion 背景 指定をしてあげることで、固定しやすさが変わってきます。

背景だけ変える・合成する方法

「もういっそ、背景を全部消して差し替えたい!」という場合は、無理に固定せず「切り抜き」ツールを使いましょう。

Stable Diffusionの拡張機能である「ABG Remover (Rembg)」を使えば、ワンクリックで背景を削除できます。

手順のイメージ:

- 背景を気にせず、人物を最高クオリティで生成する

- Rembgで背景を透明にする

- 別のプロンプトで生成した「背景画像」の上に重ねる

この「合成」の手法は、Stable Diffusion 背景 合成において最も確実な方法です。

一枚絵で完結させようとせず、素材を分けて考えるのがプロのやり方ですね。

背景モデル選びのポイント

使用しているモデル(Checkpoint)が、「人物特化」か「背景込み」かを知っていますか?

例えば、実写系の人物特化モデルだと、背景がどうしてもボケやすかったり、単調になりがちです。

Stable Diffusion 背景 モデルを選ぶ際は、以下の点に注目してください。

- 2.5D系モデル: 人物と背景のバランスが良いものが多い

- 風景特化モデル: 人物を描かずに背景素材だけ作るのに向いている

もし、あなたがこれから「生成AIを仕事にしたい」「もっと本格的な作品を作りたい」と考えているなら、こうしたモデル選びやツールの使い分けは必須スキルになります。

生成AIスクールで技術を磨く

ここまで紹介したLayerDiffuseやControlNet、合成技術などは、趣味で楽しむ分には独学でも十分です。

ただ、もしあなたが「LP制作や広告バナーに使いたい」「フリーランスとして案件を獲得したい」と考えているなら、より体系的に学ぶのも一つの手です。

例えば、バイテック生成AIスクールのような場所では、単なる画像生成だけでなく、Photoshopとの連携や、クライアントワークに耐えうる「修正・制御技術」を徹底的に教えてくれます。

スクールで学べることの例:

- Stable Diffusion 背景 固定などの高度な制御技術(ControlNetの極意など)

- 生成した素材を使ってLPやバナーを作る実践的なデザインスキル

- クラウドソーシングでの案件獲得やポートフォリオ作成支援

独学だと「エラーの解決」だけで数日潰れてしまうこともありますが、プロの指導があれば最短ルートで「稼げるスキル」として習得できます。

興味がある方は、一度チェックしてみてもいいかもしれませんね。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion 背景 固定 まとめ

それでは、今回紹介したStable Diffusionで背景を固定する方法や、うまく制御するコツについてまとめます。

- Stable Diffusionで背景を固定するにはInpaintingが基本である

- マスク機能を使えば、背景を変えずに人物だけ変更可能

- ControlNet Inpaintを使えば、より強力に構図を維持できる

- LayerDiffuseを使えば、最初から背景透明の画像が作れる

- 背景と人物を別々に生成して合成するのが最も確実な手段

- Stable Diffusion 背景 指定はプロンプトの具体性が命

- 背景を消したい時は拡張機能のRembgが便利である

- 背景がボケる時は、使用しているモデルの特性を疑うべき

- Stable Diffusion 背景 モデル選びは作品のクオリティに直結する

- LoRAを活用すれば、背景の書き込み量やスタイルを強化できる

- Inpainting時のDenoising strengthは0.5前後が目安

- Stable Diffusion 背景 おかしい時はネガティブプロンプトを見直す

- Tiled Diffusionを使うと高解像度でも背景が破綻しにくい

- 商用レベルの画像生成にはPhotoshopなどとの連携が必須

- バイテック生成AIスクールなら実務レベルの制御技術が学べる

背景のコントロールは、脱初心者への第一歩です。

今回紹介したInpaintingやControlNetを使いこなして、ぜひ理想の作品を作り上げてくださいね!

参考資料・技術ソース(一次情報)

- ControlNet (GitHub Official Repository) ※記事内で解説した「構図や背景を維持する技術(ControlNet)」の公式開発リポジトリです。

- LayerDiffuse (GitHub Official Repository) ※「背景透明化と人物生成の分離」を実現する最新技術、LayerDiffuseの公式ソースコードおよびドキュメントです。

- Rembg (GitHub Official Repository) ※背景削除のスタンダードとして紹介した、高精度な背景除去ツール「Rembg」の公式プロジェクトページです。

.jpg)