「せっかく可愛い女の子が生成できたのに、頭のてっぺんが切れちゃった…」

「全身を見たいのに、どうしても顔のアップばかりになってしまう」

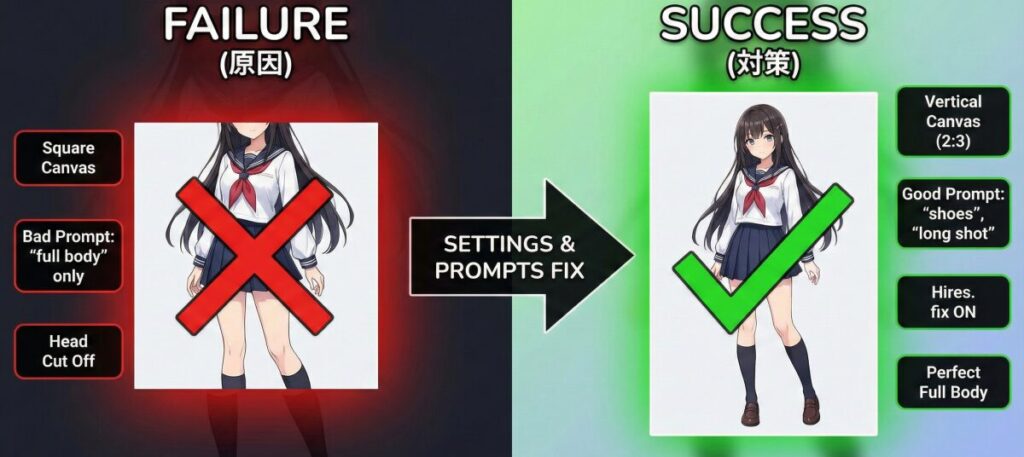

Stable Diffusionを触り始めたばかりの頃、誰もが一度はこの「全身が入らない問題」に直面するものです。足先まで入れたいのに膝で切れてしまったり、逆に全身を入れようとしたら顔が崩れてしまったり…。実はこれ、ただ「全身」と指示するだけでは解決しない、ちょっとしたコツが必要なんです。

この記事では、Stable Diffusionで思い通りの全身画像を作るための「魔法のプロンプト」や、意外と見落としがちな設定のポイントを、初心者の方にも分かりやすくお話ししていきますね。これを読めば、もう見切れに悩まされることはなくなりますよ!

この記事を読むと、以下の4点についてしっかりと理解できるようになります。

- 全身を綺麗に収めるための具体的な必須プロンプトと組み合わせ方

- 頭や足が見切れるのを防ぐアスペクト比(縦横比)の黄金ルール

- 全身を描写した際に起きやすい「顔や体の崩れ」を直すテクニック

- ControlNetなどを使って、ポーズを指定しながら全身を作る応用技

Stable Diffusionで全身プロンプトを使ってもうまくいかない原因と対策

まずは基本から押さえていきましょう。おそらく皆さんが一番知りたいのは、「なぜ全身を指定しているのにうまくいかないのか」という点だと思います。

Stable Diffusionは、基本的に正方形(512×512など)の学習データが多いため、何も指定しないと「顔がよく見える構図(ポートレート)」を描こうとする癖があります。これを矯正してあげるのが、プロンプトと設定の役割なんです。

「Stable Diffusion 全身 に ならない」を解決する基本呪文

「全身を出したい!」と思ったとき、真っ先に思いつくのは full body という単語ですよね。もちろんこれは正解なのですが、実のところこれ単体では少し弱いんです。

AIに対して「カメラをもっと引いて!」と指示を与える必要があります。おすすめの組み合わせをリストにしましたので、ぜひ試してみてください。

| プロンプト | 意味 | 効果の強さ |

| full body | 全身 | △(これだけだと弱い) |

| full shot | 全身ショット | 〇(足元まで入りやすい) |

| wide shot | 広角ショット | ◎(背景も含めて広く撮る) |

| long shot | ロングショット | ◎(カメラがかなり引く) |

| standing | 立っている | 〇(ポーズ指定で全身を促す) |

| shoes / boots | 靴 / ブーツ | ◎(足元のアイテム指定で強制的に足を描かせる) |

特に効果的なのが、「靴(shoes)」を指定することです。「靴を描く=足元までフレームに入れないといけない」とAIが判断するため、自然と全身が収まる確率がグンと上がりますよ。

「Stable Diffusion 頭が切れる」を防ぐ画角設定の重要性

いくらプロンプトで「全身」と唱えても、キャンバスが「正方形」や「横長」だと、物理的に全身を入れるのが難しくなります。人間は縦に長い生き物ですから、キャンバスも縦長にしてあげるのが鉄則です。

「Stable Diffusion 頭が切れる」とお悩みの方は、画像サイズ(Resolution)の設定を見直してみましょう。

- 推奨サイズ: 512×768(縦長)

- アスペクト比: 2:3 または 9:16

横長の画面で無理やり全身を入れようとすると、AIは人物を小さく描くしかなくなります。すると今度は、情報量が足りなくなって顔が崩れやすくなるんです。まずは「縦長設定」にする。これだけで、頭や足が見切れる失敗はかなり減りますよ。

「Stable Diffusion 体が崩れる」時の対処法とHires. fix

さて、縦長にして全身が入るようになったけれど、今度は「顔がグチャッとなる」「手足がおかしい」という現象が起きることがあります。これが「Stable Diffusion 体が崩れる」問題です。

全身を描画すると、画像全体の中で「顔」が占めるピクセル数(面積)がとても小さくなります。AIは狭いキャンバスに細かい目や口を描き込むのが苦手なので、どうしても崩れてしまうんですね。

これを解決する特効薬が、「Hires. fix(高解像度補助)」です。

- 最初は小さいサイズ(512×768など)で生成する

- Hires. fixをオンにして、1.5倍〜2倍に拡大しながら生成する

こうすることで、顔を描くためのピクセル数が増え、全身が映っていても顔がパッチリとした高画質な画像になります。Web UI(Automatic1111など)を使っている方は、ぜひチェックを入れてみてください。

「Stable Diffusion 正面 全身」を綺麗に出す構図指定

最後に、ポーズの指定です。ただ立っているだけでなく、「Stable Diffusion 正面 全身」を綺麗に見せたい場合、アングルの指定も重要になってきます。

もし、「棒立ち」を避けたいなら、以下のような視線やアングルのプロンプトを足すと、モデルのような立ち姿になります。

- looking at viewer: こっちを見ている(視線が合う)

- front view: 正面図

- cowboy shot: 膝上からのショット(全身まではいかないが、キャラを大きく見せたい時に有効)

これらを組み合わせることで、「縦長のキャンバス」に「頭からつま先まで」綺麗に収まった、魅力的な正面の全身画が完成します。

Stable Diffusionで全身を完璧に出すための応用テクニック

ここからは、さらにクオリティを上げるための応用編です。ライバルと差をつけるなら、ここまでの基本に加えて「ネガティブプロンプト」や「拡張機能」を使いこなしましょう。

プロンプトだけでは限界がある場合でも、ツールをうまく使えば「絶対に見切れない」画像を作ることができます。

「Stable Diffusion 見切れ 防止 プロンプト」とネガティブプロンプト

ポジティブプロンプト(描いてほしいもの)だけでなく、ネガティブプロンプト(描いてほしくないもの)もしっかり入力していますか?「Stable Diffusion 見切れ 防止 プロンプト」として、以下の単語は常に入れておくことを強くおすすめします。

crop, cropped, out of frame, cut off, head out of frame, feet out of frame

これらは、「切り取り」「枠外」「見切れ」を意味します。「枠外にはみ出すな!」とAIに強く禁止することで、意図しない見切れを強力に防いでくれます。

特に out of frame は効果絶大です。これをネガティブプロンプトに入れておくだけで、キャラクターが中央にギュッと収まりやすくなりますよ。

「プロンプト 全身が 見える」ためのカメラアングル調整

「プロンプト 全身が 見える」ようにするためには、カメラの位置を意識した言葉選びも大切です。

例えば、from below(下から見上げる)やfrom above(上から見下ろす)といったアングル指定を入れると、パース(遠近感)が効いたダイナミックな全身画になります。

- Dutch angle: 斜めのアングル(動きが出る)

- dynamic pose: 躍動感のあるポーズ(手足が広がるので全身が映えやすい)

ただ正面に立たせるだけでなく、こうしたカメラワークを加えることで、多少画面の端に寄っても「意図的な構図」に見え、不自然な見切れを感じさせないテクニックもあります。

「Stable Diffusion 顔が見切れる プロンプト」への対策:Outpainting

生成し終わったあとに「ああっ、最高に可愛いのに頭だけ切れてる!」という悲劇、ありますよね。そんな時は、作り直さずに「Outpainting(アウトペインティング)」という機能を使いましょう。

これは、画像の「外側」をAIに描き足してもらう技術です。

- 頭が切れている画像を読み込む

- 「上方向」に画像のキャンバスを広げる設定にする

- 生成ボタンを押す

これだけで、切れていた頭や背景が自然に継ぎ足されます。「Stable Diffusion 顔が見切れる プロンプト」を試行錯誤するよりも、「あとから足す」方が確実で早い場合も多いのです。

「Stable Diffusion 顔 写真から全身」を作るControlNet活用法

最後に、最も強力な武器を紹介します。それがControlNet(コントロールネット)です。

もしあなたが、「特定のポーズをとらせたい」「この写真のような構図にしたい」あるいは「Stable Diffusion 顔 写真から全身」を生成したいと考えているなら、ControlNetの「OpenPose」という機能が必須になります。

OpenPoseを使えば、「棒人間の骨組み」でポーズを指定できます。「万歳をして片足を上げている全身」のような複雑な指定も、プロンプトで苦戦することなく一発で決まります。

こういった高度な生成技術、特にControlNetを駆使して「思い通りの画像を100%コントロールする」スキルは、趣味だけでなく仕事でも非常に重宝されます。

例えば、「バイテック生成AIスクール」のような専門のスクールでは、こうしたControlNetを使った精密な画像生成技術をカリキュラムの中心に据えています。ただ画像が出せるだけでなく、「商業レベルで使える(指が崩れない、商品を持たせる、指定の構図を守る)」という実務スキルを学べるのが特徴です。

もし、あなたが「プロンプトガチャ(運任せの生成)」から卒業して、広告バナーやLP作成に使えるレベルの画像を自在に操りたいと思うなら、こういった実践的な環境で学ぶのも一つの近道かもしれませんね。ControlNetを使いこなせると、生成AIの世界は劇的に広がりますから。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusionで全身プロンプトを使いこなそう まとめ

ここまで、Stable Diffusionで全身を綺麗に出すためのテクニックを解説してきました。最後に、重要なポイントを整理しておきましょう。

- 全身を出す基本プロンプトは

full bodyだけでなくwide shotやlong shotを併用する。 shoes(靴)を指定することで、強制的に足元まで描画させるテクニックが有効である。- キャンバスサイズは必ず「縦長(512×768など)」に設定する。

- 顔が崩れる場合は「Hires. fix」を使って解像度を上げながら生成する。

- ネガティブプロンプトに

out of frameやcroppedを入れるのは必須である。 - ただの棒立ちを避けるなら

dynamic poseなどの動きをつける言葉を加える。 - 後から見切れを直したい場合は「Outpainting」機能で外側を描き足す。

- ポーズや構図を完全に制御したいなら「ControlNet(OpenPose)」を活用する。

- 顔のアップばかりになるのは、学習モデルの癖であることを理解しておく。

- アスペクト比を2:3や9:16にすることで、人体が自然に収まりやすくなる。

- カメラアングル(

from belowなど)を指定すると、全身が見切れても絵になる。 - プロンプトの順番も重要で、

full bodyはプロンプトの最初の方に配置する。 - ControlNetなどの高度な技術は、実務レベルの生成には不可欠である。

- 試行錯誤(ガチャ)を減らすためには、正しい「型」と「設定」を知ることが近道だ。

- これらの技術を組み合わせれば、誰でも思い通りの全身画像が生成可能である。

参考文献・引用元

- Stable Diffusionの基本構造と学習データについて

High-Resolution Image Synthesis with Latent Diffusion Models (CompVis Official GitHub)

※Stable Diffusionの基本モデル(SD1.4/1.5)が512×512の解像度で学習されている技術的根拠および公式リポジトリです。 - Hires. fix(高解像度補助)およびOutpainting機能の仕様

AUTOMATIC1111 Stable Diffusion Web UI Features (Official Wiki)

※世界で最も利用されているWeb UIツール「Automatic1111」の公式機能解説ページです。Hires. fixやアスペクト比設定の仕様が記載されています。 - ControlNet(姿勢制御技術)の技術詳細

Adding Conditional Control to Text-to-Image Diffusion Models (ControlNet Official GitHub)

※記事内で紹介した「ControlNet(OpenPose)」の開発元による公式リポジトリです。姿勢制御の仕組みや導入方法の一次情報となります。

.jpg)