「AIイラストで、キャラクターがこちらに向かって手を差し伸べるような、迫力ある絵を作りたい!」

そう思ってプロンプトを入力しても、なぜか手がぐちゃぐちゃになったり、ただ棒立ちしているだけの絵になってしまったりしませんか?

実際、Stable Diffusionにおいて「手」と「遠近感」の描写は、最も難易度が高い鬼門と言われています。

「手を前に出す」という動作は、指の形だけでなく、腕の短縮遠近法(パース)も絡んでくるため、AIが非常に混乱しやすいのです。

でも、諦めないでください。

現在は便利な拡張機能や、特定のプロンプトの組み合わせによって、この問題を劇的に改善できます。

このとき重要になるのが、単に「手を出す」と指示するだけでなく、「どのようなカメラワークで、どう制御するか」を知っているかどうかです。

この記事では、初心者がつまずきがちなポイントを解消し、思い通りの構図を作るためのテクニックを余すことなくお伝えします。

この記事を読むと、Stable Diffusionで手を前に出す方法について以下のことが理解できます。

- 迫力ある構図を作るための具体的なプロンプト(呪文)の組み合わせ

- 崩れやすい指や腕の形を制御するためのControlNetの基本設定

- Depth Libraryを使って、理想の手のポーズをピンポイントで指定する方法

- 生成AIスキルを実務レベルに引き上げ、思い通りの作品を作るための道筋

Stable Diffusionで手を前に出すプロンプトのコツ

まずは、基本となるプロンプト(呪文)から見ていきましょう。

拡張機能も強力ですが、ベースとなる指示が間違っていると、AIは意図を汲み取れません。

ここでは、私が普段試行錯誤する中で「これは効く!」と感じたキーワードを厳選して紹介します。

「手を伸ばす」を表現する呪文

手を前に出すためには、動作そのものを表す単語と、方向を指定する単語を組み合わせる必要があります。

単純に「hand(手)」と書くだけでは、身体の横に下がっているだけの手が生成されがちです。

最も基本かつ強力なのは、reaching out(手を伸ばす)や reaching towards viewer(見る人に向かって手を伸ばす)という表現です。

これを入れるだけで、AIは「画面の手前側にアクションを起こすべきだ」と認識します。

また、より具体的な描写を加えたい場合は、以下の単語を組み合わせてみてください。

- arm outstretched(腕を伸ばす)

- hand reaching out(手を差し伸べる)

- fingers spreading(指を広げる:迫力を出すのにおすすめ)

- focus on hand(手に焦点を合わせる)

これらを組み合わせることで、AIに対して「何を描くべきか」を強く意識させることができます。

視点を操るプロンプト

しかし、動作の指定だけでは不十分なことがあります。

なぜなら、「手を前に出す」という構図は、カメラのレンズ効果(パース) が効いていないと、迫力が伝わらないからです。

例えば、広角レンズで撮影したような、手前が大きく奥が小さく見える効果を狙うと、成功率がグッと上がります。

私がよく使うのは、fisheye(魚眼レンズ)や wide angle(広角)といったキーワードです。

具体的には、以下のプロンプトを先頭付近に入れてみてください。

- from above(上からの視点:上目遣いで手を伸ばす構図向け)

- dynamic angle(躍動感のあるアングル)

- foreshortening(短縮遠近法:手前の物体を大きく強調する技法)

- depth of field(被写界深度:背景をボカして手を強調する)

特に foreshortening は、手を大きく、顔を少し奥に見せるような構図において魔法のような効果を発揮します。

これを理解した上でプロンプトを組むと、一気にプロっぽい仕上がりになりますよ。

ネガティブプロンプトの重要性

そしてもう一つ、忘れてはいけないのがネガティブプロンプトです。

手を前に出す構図は情報量が多いため、AIが混乱して「指が増える」「腕が3本になる」「指が融合する」といったエラーが頻発します。

これを防ぐために、あらかじめ「描いてほしくない要素」を強く否定しておきましょう。

| プロンプト | 意味 | 効果 |

| bad anatomy | 崩れた解剖学 | 体の構造的な矛盾を防ぐ |

| extra digits | 余分な指 | 6本指になるのを防ぐ |

| missing fingers | 指の欠損 | 指が足りなくなるのを防ぐ |

| fused fingers | 融合した指 | 指同士がくっつくのを防ぐ |

| bad hands | 崩れた手 | 手全体のクオリティ低下を防ぐ |

もちろん、これらを入れても100%成功するわけではありませんが、打率は確実に上がります。

基本設定としてこれらを常に入れておくことをおすすめします。

Stable Diffusionで手を前に出すならControlNetが必須

プロンプトだけで理想の「手を前に出す」画像が出れば苦労はありませんが、実際はガチャ(運任せ)になりがちです。

そこで登場するのが、ControlNet(コントロールネット) です。

現在の画像生成において、意図した構図を作るならこれを使わない手はありません。

特に「手」に関しては、ControlNetを使うか使わないかで、作業時間が数時間変わると言っても過言ではないでしょう。

Depth Libraryで手の形を指定

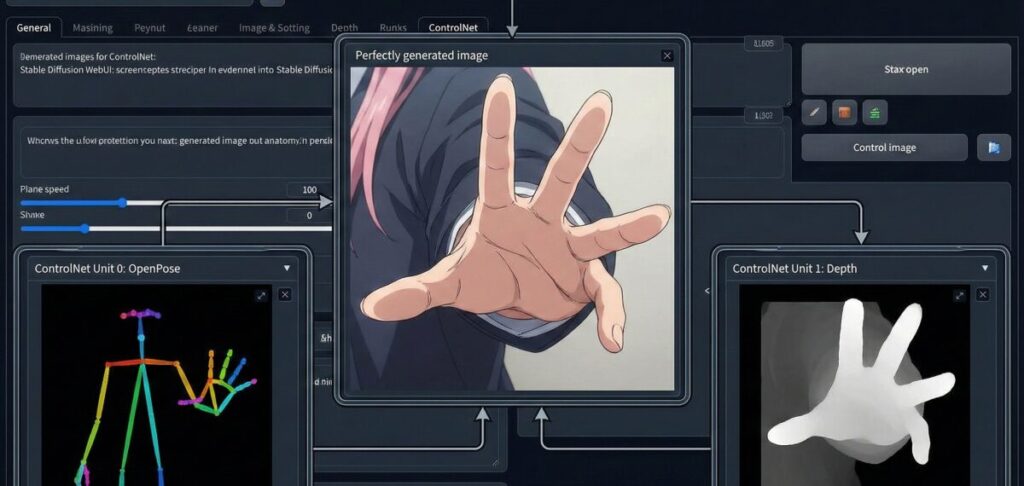

私が「手を前に出す」構図で最もおすすめしたいのが、ControlNetの「Depth」と、拡張機能「Depth Library」の組み合わせです。

通常、ポーズ指定といえば「OpenPose」が有名ですが、OpenPoseは「骨組み(棒人間)」で指定するため、手のひらの向きや指の前後関係(パース)を伝えるのが苦手です。

一方、Depth(深度情報)は「物体との距離」をAIに伝えるため、「手が顔よりも手前にある」という立体的な情報を正確に認識させることができます。

ここで役立つのが「Depth Library」という拡張機能です。

これを導入すると、ControlNet上の画面に「3Dの手のモデル」を呼び出し、自由に回転させたり指を曲げたりして配置できます。

つまり、「あらかじめ理想の手のポーズ画像を自分で作って、それを下書きに清書させる」ことができるのです。

こうすれば、「手をもっと大きく見せたい」「小指だけ少し曲げたい」といった微調整も自由自在です。

Depthマップを使用することで、手が画面から飛び出してくるような立体感を損なわずに生成できます。

OpenPoseで全身のポーズ制御

ただ、Depthだけでは「腕がどこから生えているか」という身体全体の整合性が取れなくなることがあります。

そんなときは、OpenPoseも併用しましょう。

ControlNetは複数のユニット(Multi-ControlNet)を同時に使えるので、「Unit 0」でDepthを使い手を制御し、「Unit 1」でOpenPoseを使って体のポーズを固定する、という使い方が最強です。

OpenPoseのエディタを使えば、肩の位置や肘の角度を指定できます。

「手を前に出す」場合、肘が体の後ろや横に隠れることが多いですが、OpenPoseで肩と手首の位置関係をしっかり指定してあげることで、不自然に長い腕や、関節がおかしい腕が生成されるのを防げます。

もし、それでも指が崩れてしまう場合は、ControlNetの適用タイミング(Ending Control Step)を少し早め(0.8くらい)にして、最後はAIの描画力に任せるという調整も有効です。

崩れた指を修正するテクニック

それでもなお、指が一本多かったり、形が変だったりすることはあります。

AI生成において、一発で完璧な手が出ることは稀だからです。

ここで諦めて画像を削除するのではなく、Inpaint(インペイント) 機能を使って修正しましょう。

具体的には、生成された画像の「手」の部分だけをマスク(黒く塗りつぶす)し、その部分だけを再生成させます。

このとき、「Only masked(マスク部分のみ)」の設定にすると、高解像度で手だけを描き直してくれるので、ディテールが向上します。

また、ADetailer という拡張機能を入れておくと、画像生成と同時に「顔」や「手」を自動検知して修正をかけてくれます。

特に hand_yolov8n.pt などのモデルを設定しておくと、手を認識して自動で綺麗に書き直してくれるので、大量に生成する際は必須のツールと言えるでしょう。

拡張機能でさらにクオリティアップ

ここまで紹介した技術は、慣れてしまえばルーティンワークになりますが、最初は設定項目が多くて難しく感じるかもしれません。

ただ単に趣味で楽しむ分には時間をかけても良いですが、「ブログのアイキャッチに使いたい」「仕事でバナーを作りたい」という場合は、効率も重要ですよね。

実は、こうした高度な生成AI技術は、独学だと情報のアップデートが速すぎて追いつくのが大変です。

もしあなたが、趣味の範囲を超えて、「生成AIを仕事に活かしたい」「クリエイティブな副業を始めたい」 と考えているなら、体系的に学べる環境に身を置くのも一つの近道です。

例えば、「バイテック生成AIスクール」 のような場所では、MidjourneyやStable Diffusionを使った商業レベルの画像生成技術を教えてくれます。

単なるツールの使い方だけでなく、今回のようなControlNetの精密な制御や、それをどうやってLP(ランディングページ)や広告バナーといった「仕事」に落とし込むかまで学べるのが特徴です。

実案件獲得のサポートまであるので、スキルを収益に変えたい人には心強い味方になるはずです。

こうしてスキルを磨いていくと、AI特有の「手」の違和感も、プロレベルで修正できるようになりますよ。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusionで手を前に出す方法まとめ

ここまで、Stable Diffusionで手を前に出すためのプロンプトやControlNetの活用法について解説してきました。

最後に、要点を振り返ってみましょう。

- 手を描くのはAIにとって最難関のタスクである。

- 基本プロンプトは

reaching outやreaching towards viewerが有効。 - 迫力を出すには

foreshorteningなどのパース用呪文を組み合わせる。 bad anatomyなどのネガティブプロンプトは必須のお守り。- プロンプトだけで制御するのは限界があるためControlNetを使う。

- 手前の距離感を出すにはOpenPoseよりもDepthが有利である。

- Depth Libraryを使えば、3Dの手を配置して直感的に構図を作れる。

- 全身の整合性を取るならOpenPoseとDepthを併用する。

- 一発成功を狙わず、InpaintやADetailerでの修正を前提にする。

- Inpaintは「Only masked」で解像度を高めて書き直す。

- ADetailerを導入すると自動で手の修正を行ってくれる。

- 視点操作のプロンプト(魚眼レンズなど)も効果的。

- 技術の習得には試行錯誤が必要だが、ツールで効率化できる。

- 実務レベルを目指すなら専門スクールでの学習も近道である。

- 正しい知識があれば、AIでも意図通りの迫力ある絵は作れる。

この記事の信頼性を支える参考資料(一次情報)

- ControlNetの技術的基盤と仕組みについて

記事内で紹介した「構図やポーズを制御する技術」の原典となる学術論文です。

Adding Conditional Control to Text-to-Image Diffusion Models(出典:Cornell University arXiv) - OpenPose(人体姿勢推定)の原理について

「棒人間」でポーズを指定する技術のベースとなっている、カーネギーメロン大学の研究プロジェクト公式サイトです。

OpenPose: Real-time multi-person keypoint detection library for body, foot, hand, and facial estimation(出典:Carnegie Mellon University Perceptual Computing Lab) - Stable Diffusionの開発とモデルについて

画像生成AIの基盤モデルを提供しているStability AI社の公式情報です。

Stable Diffusion – Stability AI(出典:Stability AI 公式サイト)

.jpg)