- 「画像生成AIを始めたけれど、生成ボタンを押してから完成するまでがあまりにも遅い…」

- 「メモリ不足エラー(OOM)が出てしまって、高画質の画像が作れない…」

あなたは今、このような悩みを抱えてパソコンの前でため息をついていませんか?

私もStable Diffusionを使い始めた当初は、グラフィックボードのファンが唸りを上げるだけで一向に画像が出てこず、何度も再起動を繰り返していました。

でも、安心してください。

Stable Diffusionは、設定を見直したり、最新の軽量化技術を取り入れたりするだけで、劇的に動作を軽くすることができます。

それはまるで、重たい荷物を降ろして全力疾走できるようになるようなものです。

この記事では、基本的な設定の見直しから、2025年の最新トレンドである高速化技術まで、初心者の方にも分かりやすく丁寧に解説していきます。

パソコンのスペックを買い替えなくても、今の環境でできる工夫はたくさんあります。

一緒に設定を見直して、ストレスフリーな画像生成環境を手に入れましょう!

この記事を読むと、以下のことが理解できるようになります。

- 重い動作を解消するための基本的な設定とコマンドライン引数の使い方

- xformersやNVIDIA設定など、システム面からの具体的な高速化アプローチ

- 2025年のトレンドであるLCMやSDXL Lightningを活用した爆速生成テクニック

- 生成スピードを上げることで広がる、実務レベルでのAI活用術

Stable Diffusionの軽量化と高速化の基本テクニック

まずは、誰でもすぐに実践できる基本的な軽量化テクニックから見ていきましょう。

「軽量化」と聞くと難しそうに感じるかもしれませんが、実はちょっとした設定を変えるだけで、見違えるほど快適になることが多いのです。

ここでは、ツールの設定やパソコン内部の整理など、基礎体力となる部分を整えていきます。

遅い原因を特定して対策する

Stable Diffusionが遅いと感じるとき、その原因は一つではありません。

多くは「VRAM(ビデオメモリ)不足」か「計算負荷が高すぎる設定」のどちらか、あるいはその両方に原因があります。

例えば、画像サイズを無闇に大きくしていませんか?

初期設定の512×512や1024×1024から、いきなり2倍、3倍のサイズで生成しようとすると、計算量は二乗で増えていきます。

また、ブラウザでYouTubeを開きながら、Photoshopも起動して…というように、バックグラウンドで他の重いアプリが動いていると、Stable Diffusionに使えるメモリが圧迫されてしまいます。

私がおすすめするのは、まず「タスクマネージャー」を開いて、GPUのメモリ使用率を確認してみることです。

生成中にメモリが天井(100%)に張り付いているなら、明らかにVRAM不足です。

この場合、後述する軽量化オプションを使うか、画像サイズを小さくして生成し、後から「アップスケール(拡大)」する手順に変えるのが効果的です。

まずは自分の環境のどこにボトルネックがあるのかを知ることから始めましょう。

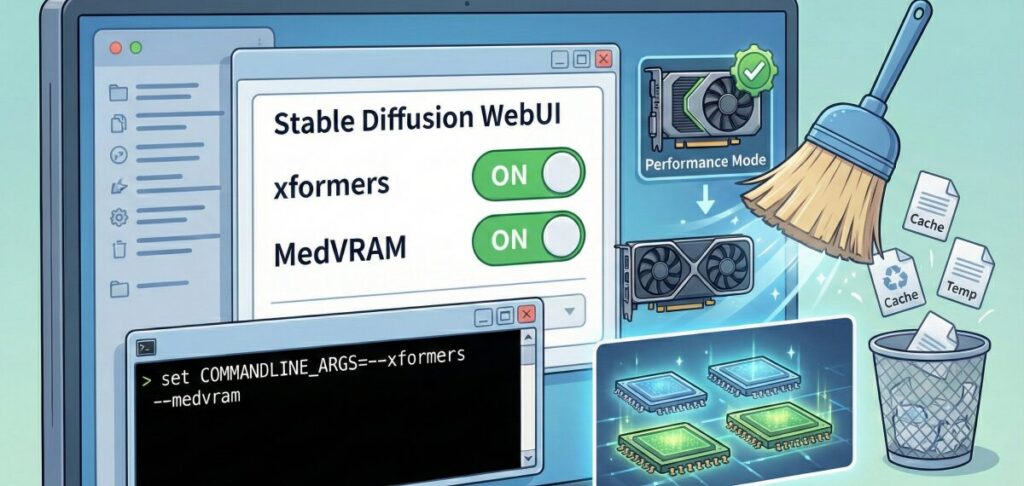

コマンドライン引数で高速化オプションを設定

Stable Diffusion WebUI(Automatic1111など)には、起動時に読み込ませることで動作を制御できる「コマンドライン引数」という魔法の言葉があります。

これを設定ファイル(webui-user.bat)に書き加えるだけで、メモリ消費を抑えたり、計算速度を上げたりできます。

初心者の方がまず試すべき、代表的なオプションを表にまとめました。

| オプション | 効果 | おすすめのユーザー |

| –xformers | メモリ消費を大幅に削減し、生成速度も向上させる定番の設定。 | ほぼ全員(NVIDIAユーザー) |

| –medvram | VRAMが中程度(4GB〜6GB)の場合に、速度を少し犠牲にしてメモリ不足を防ぐ。 | エラーが頻発する人 |

| –lowvram | VRAMが非常に少ない(4GB未満)場合に、極限までメモリを節約する。速度は遅くなる。 | 古いPCを使っている人 |

| –opt-sdp-attention | xformersを使わずにPyTorchの機能で高速化する。環境によってはxformersより速い。 | 最新版を使っている人 |

設定方法は簡単です。

webui-user.batを右クリックして「編集」を選び、set COMMANDLINE_ARGS=の後に、スペースを空けて記述するだけです。

例えば、set COMMANDLINE_ARGS=–xformers –medvram のように記述します。

これだけで、「今まで動かなかった高解像度生成ができるようになった!」という声も多いので、ぜひ試してみてください。

xformersの導入とメモリ割り当ての最適化

前述のコマンドライン引数でも触れましたが、xformersはStable Diffusionの高速化において、もはや必須と言えるライブラリです。

これは、画像生成の核心部分である「Attention(注意機構)」の計算を効率化してくれるものです。

導入すると、VRAMの使用量が減るだけでなく、生成スピードも体感できるレベルで向上します。

「画質が落ちるのでは?」と心配される方もいますが、実用上ほとんど差は感じられません。

むしろ、同じ時間でより多くの枚数を生成できるメリットの方が圧倒的に大きいです。

また、メモリ割り当てについても意識してみましょう。

WebUIの設定タブの中に、VAEやモデルをVRAMに常駐させるか、適宜RAM(メインメモリ)に逃がすかを決める設定があります。

VRAMに余裕があるなら「すべてVRAMに置く」設定が最速ですが、ギリギリの場合は「Tiled VAE」などの拡張機能を使って、画像を分割して処理させることで、メモリ溢れを防ぐことができます。

自分のハードウェアに合わせて、無理のない割り当てを見つけるのがコツです。

不要なキャッシュ削除とモデル整理

「最近、なんだか起動が遅いし、ハードディスクの空き容量も減ってきた…」

そう感じたら、キャッシュファイルや使っていないモデルデータが圧迫している可能性があります。

Stable Diffusionは、一度生成した際の一時ファイルや、モデルの変換データなどをキャッシュとして保存することがあります。

また、Civitaiなどのサイトから「良さそうだから」と片っ端からダウンロードしたCheckpoint(モデル)やLoRAファイルが、数GB単位でストレージを占拠していませんか?

ストレージの空き容量が少なくなると、PC全体のパフォーマンスが落ち、結果として仮想メモリの動作も遅くなります。

定期的にoutputsフォルダの中身を整理したり、使わないモデルは削除、あるいは外付けHDDに移動させたりしましょう。

PCの中身をスッキリさせることは、Stable Diffusionの軽量化だけでなく、精神衛生的にも良い効果がありますよ。

NVIDIA設定でのパフォーマンス向上

最後に、ハードウェア側、特にNVIDIA製グラフィックボードの設定を見直しましょう。

Windowsのデスクトップを右クリックして「NVIDIA コントロールパネル」を開いてみてください。

「3D設定の管理」の中に、「電源管理モード」という項目があります。

これがデフォルトだと「標準」や「電力最適化」になっていることが多いのですが、これを「パフォーマンス最大化を優先」に変更します。

こうすることで、GPUが省エネを気にせず、常に全力で計算してくれるようになります。

また、ドライバ(Studio DriverまたはGame Ready Driver)を最新の状態に保つことも重要です。

新しいドライバには、最新のAI処理に最適化された修正が含まれていることが多いからです。

「たかが設定、されど設定」。

こうした細かい積み重ねが、最終的に「1枚あたり数秒の短縮」につながり、100枚生成した時には大きな時間の差となって返ってきます。

2025年版!Stable Diffusion軽量化の最新トレンドと応用

基本的な設定ができたら、次はもっと劇的に速度を上げる「新しい技術」に目を向けてみましょう。

AIの世界は日進月歩で、2024年から2025年にかけて、生成速度を根本から変えるような技術が次々と登場しています。

これらを知っているかいないかで、作業効率は何倍も変わってきます。

LCMとSDXL Lightningで爆速生成

2025年の高速化トレンドを語る上で外せないのが、LCM (Latent Consistency Models) や SDXL Lightning といった技術です。

これまでのStable Diffusionでは、きれいな画像を作るために「20〜30回(ステップ数)」の計算を繰り返すのが一般的でした。

しかし、これらの新技術を使うと、なんと「4〜8回」の計算で高品質な画像が完成してしまうのです。

単純計算で、時間が4分の1から5分の1になります。

実際に使ってみると、「生成ボタンを押した瞬間に画像が出ている」という感覚に近く、最初は本当に驚きます。

導入も簡単で、専用のLoRAを読み込ませたり、対応しているCheckpointモデルに切り替えたりするだけです。

特にSDXLという高画質・高負荷なモデルを使いたい場合、Lightningモデルを使えば、軽量なSD1.5系と同じくらいの軽快さで動かすことができます。

「重いからSDXLは諦めていた」という方にこそ、ぜひ試してほしい技術です。

LoRAを使った軽量化と効率的な学習

LoRA (Low-Rank Adaptation) は、特定のキャラクターや画風を追加学習させるための技術として有名ですが、実は「軽量化」の観点からも非常に優秀です。

巨大なCheckpointモデル(数GB)を何個も切り替えて使うよりも、ベースとなる軽量なモデルを一つ決めておき、そこに数百MB程度の軽いLoRAを付け替える運用の方が、ストレージにもメモリにも優しいからです。

ただし、注意点もあります。

「あれもこれも」と欲張って、複数のLoRAを同時にたくさん読み込ませすぎると、逆に計算処理が重くなり、生成速度が落ちてしまいます。

料理で例えるなら、スパイスは適量がおいしいのと同じです。

通常は1〜2個、多くても3個程度に留めておくのが、速度と画質のバランスを保つコツです。

生成AIスキルを実務に活かす方法

ここまで高速化・軽量化の技術をお伝えしてきましたが、なぜ私たちはこれほどまでに「速さ」を求めるのでしょうか?

もちろん、趣味でたくさんの画像を見たいというのも大きな理由です。

しかし、それ以上に「試行回数を増やして、より質の高い作品を短時間で作れるようになる」ことは、このスキルを仕事や副業に活かすための強力な武器になります。

実際、生成スピードが上がれば、クライアントからの修正依頼にも即座に対応できますし、ブログのアイキャッチ画像や広告バナーなどを量産する際にも圧倒的な強みになります。

もしあなたが、「もっと本格的にStable Diffusionを使いこなしたい」「このスキルを将来の仕事に繋げたい」と考えているなら、独学だけでなく、体系的に学べる環境に身を置くのも一つの手です。

その中の一つに、バイテック生成AIスクールという選択肢があります。

ここは単にツールの使い方を教えるだけでなく、実務でどう活用するか、どうやって収益化につなげるかという「実践」に特化したオンラインスクールです。

今日学んだような高速化の知識も、プロの現場でどう活かせば「即戦力」のアウトプットになるのか、より深く学ぶことができるでしょう。

興味があれば、一度チェックしてみると、あなたのAIクリエイターとしての道が大きく開けるかもしれません。

Tiled VAEと低VRAM向け設定の活用

最後に、もう一つ実践的なテクニックを紹介します。

高解像度の画像を生成しようとしてエラーが出るとき、「Tiled VAE」(またはTiled Diffusion)という拡張機能が救世主になります。

これは、一枚の大きな画像を小さなタイル状に分割して、順番に処理していく技術です。

一度に処理するデータ量が小さくなるため、VRAMが少ないグラフィックボードでも、驚くほど巨大な画像のアップスケールが可能になります。

時間は少しかかりますが、「メモリ不足で落ちる」という最悪の事態はほぼ回避できます。

また、WebUIの設定で「低VRAMモード」を有効にしたり、プレビュー画面の更新頻度を下げたりすることも、地味ながら効果があります。

自分のPCスペックと相談しながら、「速度優先の設定」と「画質・解像度優先の設定」を使い分けられるようになると、Stable Diffusion上級者への仲間入りです。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion 軽量化まとめ

いかがでしたでしょうか。

Stable Diffusionの軽量化は、単に「待ち時間を減らす」だけでなく、あなたの創造性を妨げるストレスを取り除き、もっと自由に、もっと楽しく創作活動に没頭するための重要なステップです。

今回ご紹介した内容は、どれも今日から試せるものばかりです。

まずは一つずつ設定を見直して、その変化を体感してみてください。

サクサク画像が生成される快感を味わうと、もう元の設定には戻れなくなるはずです。

それでは、最後にこの記事の要点をまとめます。

- まずはタスクマネージャーで自分のPCのボトルネック(特にVRAM)を確認すること

- コマンドライン引数(

--xformersなど)は必須級の高速化設定である --medvramや--lowvramを使えば、スペックの低いPCでも動作可能になる- NVIDIAコントロールパネルで「パフォーマンス最大化」を設定すること

- 不要なキャッシュや使わないモデルを削除し、ストレージを圧迫させない

- 画像サイズを無闇に上げず、基本サイズで生成してから拡大するのが基本

- 2025年のトレンドはLCMやSDXL Lightningによる「少ないステップ数」での生成

- LCMを使えば、生成時間を従来の4分の1以下に短縮できる可能性がある

- LoRAは便利だが、読み込みすぎると逆に重くなるので適量を守る

- Tiled VAEを活用すれば、低スペックでも高解像度画像の生成が可能になる

- ドライバやWebUI自体を最新版に保つことも、パフォーマンス向上の鍵

- 高速化は「試行回数」を増やし、作品のクオリティアップに直結する

- 快適な環境作りは、AIスキルを実務や副業で活かすための第一歩である

- 設定変更は一度に行わず、一つずつ効果を確認しながら行うのがコツ

- 軽量化で浮いた時間を、プロンプトの研究や新しいアイデア出しに使おう

本記事の執筆にあたり参照した信頼性の高い公式情報

この記事で解説した技術や設定値は、以下の開発者公式ドキュメントおよび研究発表に基づいています。より専門的な詳細を確認したい場合は、各一次情報をご確認ください。

- xformersライブラリ(メモリ効率化技術)

(出典:Meta Research 公式GitHubリポジトリ)

※Stable Diffusionの高速化に不可欠な「xformers」を開発したMeta社(Facebook Research)による技術仕様とソースコードです。 - Stable Diffusion WebUI 最適化ガイド

(出典:Automatic1111 公式Wiki – Optimizations)

※世界で最も利用されているWebUIツールの開発コミュニティによる、公式のメモリ管理およびコマンドライン引数の仕様書です。 - Latent Consistency Models (LCM) 研究プロジェクト

(出典:清華大学学際情報研究院 – LCM Project Page)

※2025年の高速化トレンドである「LCM」技術を発表した研究チームによる、高速推論アルゴリズムに関する一次論文とプロジェクト詳細です。

.jpg)