生成AIで自分好みのキャラクターを作っているとき、「顔やポーズは完璧なのに、服だけ変えたい!」と思ったことはありませんか?

実は、Stable Diffusionを使えば、キャラクターの同一性を保ったまま衣装だけを自由自在に着せ替えることが可能です。

一見難しそうに感じるかもしれませんが、プロンプトのコツや便利な機能を覚えれば、誰でもファッションショーのように次々と服を変えられるようになりますよ。この記事では、初心者の方でも迷わず実践できるように、具体的な手順や魔法のような呪文(プロンプト)をわかりやすく解説しますね。

この記事を読むと以下のことが理解できます:

- プロンプトだけで思い通りの服装を指定する基本テクニック

- Inpainting機能を使って画像の一部(服)だけを作り直す方法

- LoRAやControlNetを活用した高度な着せ替え術

- 生成した画像のクオリティを上げ、仕事に繋げるための視点

Stable Diffusionで衣装を変更する具体的な方法

まずは、Stable Diffusionを使って衣装を変更するための、基礎から応用までの具体的なアプローチを見ていきましょう。

大きく分けて「プロンプトで指定する」「Inpaintingで部分修正する」「拡張機能を使う」という3つのステップがあります。

プロンプト(呪文)で服装を指定する基本

最も基本的な方法は、プロンプト(呪文)を工夫することです。

画像生成を行う際、ただ「服」と入力するのではなく、具体的な形状、素材、色を指定することで、AIに明確な指示を出せます。

初心者が覚えておくべき、代表的な衣装プロンプトをリストにまとめました。

| カテゴリ | プロンプト例 | 日本語訳 |

| 日常着 | casual clothes, t-shirt, jeans, hoodie | カジュアルな服、Tシャツ、ジーンズ、パーカー |

| 制服系 | school uniform, sailor dress, blazer | 制服、セーラー服、ブレザー |

| フォーマル | suit, evening dress, tuxedo | スーツ、イブニングドレス、タキシード |

| ファンタジー | armor, robe, wizard outfit | 鎧、ローブ、魔法使いの服 |

| 水着・運動 | bikini, gym clothes, sportswear | ビキニ、体操服、スポーツウェア |

このように言えば簡単そうですが、プロンプトだけだと「顔が変わってしまう」という問題が起きがちです。

そこで次に紹介するInpaintingが重要になります。

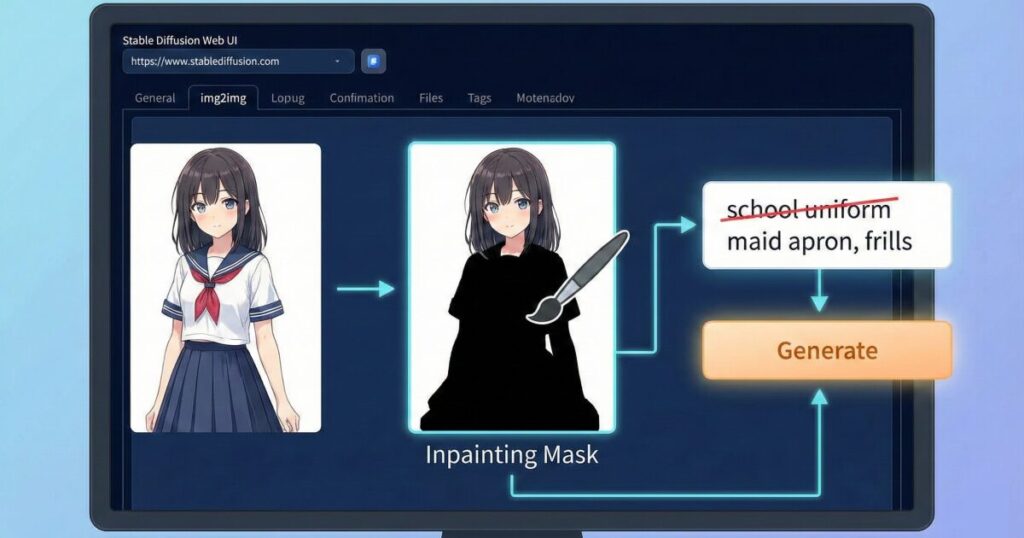

Inpaintingで部分的に着せ替える手順

「今の顔が気に入っているから、ここだけは変えたくない!」

そんな時は、Stable Diffusionの標準機能であるInpainting(インペインティング)を使います。これは画像の指定した部分だけを再生成する技術です。

具体的な手順は以下の通りです。

- img2imgタブを開く: 生成した画像を「Inpaint」タブに送ります。

- マスクを塗る: ブラシツールを使って、変更したい「衣装の部分」だけを黒く塗りつぶします(マスク)。

- プロンプトを変更: 顔に関するプロンプトはそのままに、衣装のプロンプトだけ書き換えます(例:

school uniform→maid apron)。 - 生成ボタンを押す: 顔や背景はそのまま維持され、塗りつぶした部分だけ新しい衣装が生成されます。

このとき、Denoising strength(ノイズ除去強度)を0.6〜0.7くらいに設定するのがコツです。数値が低すぎると元の服が残り、高すぎると背景と馴染まないことがあります。

LoRAを使って特定のコスチュームを着せる

アニメやゲームの特定のキャラクターの衣装や、非常に複雑なデザインの服を着せたい場合は、LoRA(Low-Rank Adaptation)という追加学習データを使うのが効果的です。

Civitaiなどのサイトから衣装専用のLoRAモデルをダウンロードし、プロンプトに組み込むだけで、通常では再現が難しいディテールまで表現できます。

- メリット: 特定の作品の衣装や、特殊なファッション(サイバーパンク風など)を一発で出せる。

- 注意点: LoRAの適用強度(Weight)が高すぎると画風が崩れるため、

<lora:costume_name:0.7>のように数値を調整しましょう。

拡張機能ControlNetを活用する

さらに精度を高めたいなら、ControlNetという拡張機能が欠かせません。

特に「OpenPose」や「Canny」という機能を使うと便利です。

- OpenPose: キャラクターのポーズを固定したまま、服だけを変えることができます。

- Canny: 元画像の線画を抽出して維持するため、服のシワやドレープ感をある程度残したまま、色や柄を変えることが可能です。

これらを組み合わせることで、「ポーズはそのまま、服のデザインだけガラッと変える」というプロのような編集が可能になります。

Stable Diffusionの衣装生成で失敗しないコツと注意点

ここからは、Stable Diffusionでの衣装生成において、よりクオリティを上げるためのコツや、やってしまいがちな失敗への対策をお伝えします。

ただ生成するだけでなく「使える」画像にするためのポイントです。

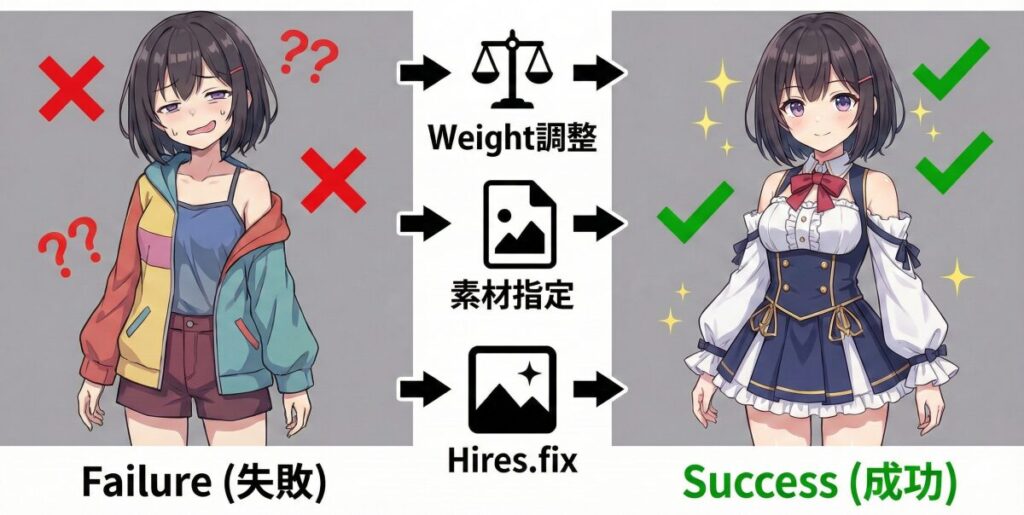

服装の重み付け(Weight)を調整する

プロンプトを入れても、AIが指示を無視して勝手に別の服を着せることがあります。

これは学習モデルのバイアス(偏り)によるものです。

そんな時は、プロンプトの重み付け(Weight)を行いましょう。

強調したい単語をカッコで囲むことで、AIに「これは重要!」と伝えることができます。

(red dress:1.2)-> 赤いドレスの要素を1.2倍強調((bikini))-> 二重括弧でさらに強調

ただし、数値を上げすぎると画像が崩れる原因になるので、1.1〜1.5の範囲で少しずつ調整するのがおすすめです。

色や素材を細かく指定するテクニック

「白い服」とだけ指定しても、AIは布なのかシルクなのか分かりません。

リアリティを出すには、素材(マテリアル)を指定するのがプロの技です。

- 光沢感を出したい:

silk,satin,glossy - カジュアル感を出したい:

denim,cotton,knit - ハードな印象にしたい:

leather,latex,metal armor

また、色に関しても単にblueとするより、navy blueやpastel blueのように具体的に指定することで、理想に近い仕上がりになります。

自然な仕上がりにするための修正フロー

生成した画像の「首元」や「袖口」が不自然に切れていたり、肌と服の境界線が曖昧だったりすることがあります。

これを修正するには、Hires.fix(高解像度化)を活用しましょう。

一度生成した画像をアップスケール(拡大)しながら再描画することで、細かいディテールが書き込まれ、服の刺繍やボタンなどの装飾が驚くほど鮮明になります。

「なんとなくボヤッとしているな」と感じたら、Hires.fixをオンにして再生成してみてください。

生成AIを仕事にするならスクールも検討

ここまで紹介した技術を使えば、趣味の範囲では十分楽しめます。

しかし、もしあなたが「このスキルで副業をしたい」「企業の広告バナーやLPを作りたい」と考えているなら、独学だけでは限界が来るかもしれません。

特に商用利用においては、著作権への配慮や、クライアントの要望通りに100%コントロールする高度な技術(ControlNetのフル活用など)が求められます。

そこで選択肢の一つとしておすすめなのが、バイテック生成AIスクールのような専門スクールです。

ここは単なる操作説明だけでなく、「実務でどう稼ぐか」に特化しているのが特徴です。

- 実務直結: 綺麗な絵を作るだけでなく、LP制作や商用画像として使えるレベルのアウトプットを学びます。

- 案件獲得サポート: スキルを身につけた後、実際にクラウドソーシングなどで仕事を取るためのポートフォリオ作成や営業文の添削までサポートしてくれます。

趣味から一歩進んで、生成AIを「武器」にしたい方は、こうした環境で体系的に学ぶのも近道ですよ。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion 衣装 まとめ

この記事では、Stable Diffusionを使ってキャラクターの衣装を変更する方法について詳しく解説しました。

最後に、重要なポイントをまとめます。

- 衣装変更の基本はプロンプトでの具体的な指示である

- 英単語で形状・素材・色を指定すると精度が上がる

- 顔を変えずに服だけ変えるならInpaintingが必須である

- Inpaintingでは変更したい部分だけをマスクする

- LoRAを使えば特定のアニメ衣装なども再現可能になる

- ControlNetを使えばポーズを固定したまま着せ替えできる

- プロンプトの重み付けでAIへの指示強度を調整する

- 素材(シルク、デニム等)の指定でリアリティが増す

- Hires.fixを使うと細部の書き込みが綺麗になる

- ノイズ除去強度の設定が自然な合成の鍵である

- マスクの境界をぼかす設定で肌との馴染みが良くなる

- 商用レベルを目指すなら独学よりスクールが早い

- バイテック生成AIスクールは収益化に特化している

- 実務では法的な知識や細部のコントロール力が問われる

- まずはInpainting機能から触ってみるのがおすすめ

参考資料・公的情報源

- 技術的根拠(原著論文)

High-Resolution Image Synthesis With Latent Diffusion Models (CVPR 2022)

Stable Diffusionの基盤技術である「潜在拡散モデル」に関する、ミュンヘン大学(LMU)等の研究チームによる原著論文です。技術的な信頼性を担保する一次情報です。 - 公式リポジトリ(開発元)

CompVis/stable-diffusion: A latent text-to-image diffusion model (GitHub)

Stable Diffusion V1の公式コードおよびモデルウェイトが公開されている、ハイデルベルク大学CompVisグループの公式リポジトリです。 - 法的ガイドライン(文化庁)

AIと著作権に関するチェックリスト&ガイダンス (文化庁)

生成AIを利用する際の著作権侵害リスクや、依拠性の考え方についてまとめられた、日本国政府(文化庁)による公式ガイドラインです。商用利用時の法的根拠となります。

.jpg)