Stable Diffusionを使っていて、「生成された画像は素晴らしいのに、手の修正だけがうまくいかない」「背景に余計なものを消す作業が大変だ」といった悩みに直面していませんか?

Stable Diffusionは、もはやただの画像生成ツールではなく、あなたの創造性を形にするための強力なパートナーです。しかし、細部までこだわりたい、特に商業利用を考えている場合、少しの違和感が大きな問題になりかねません。

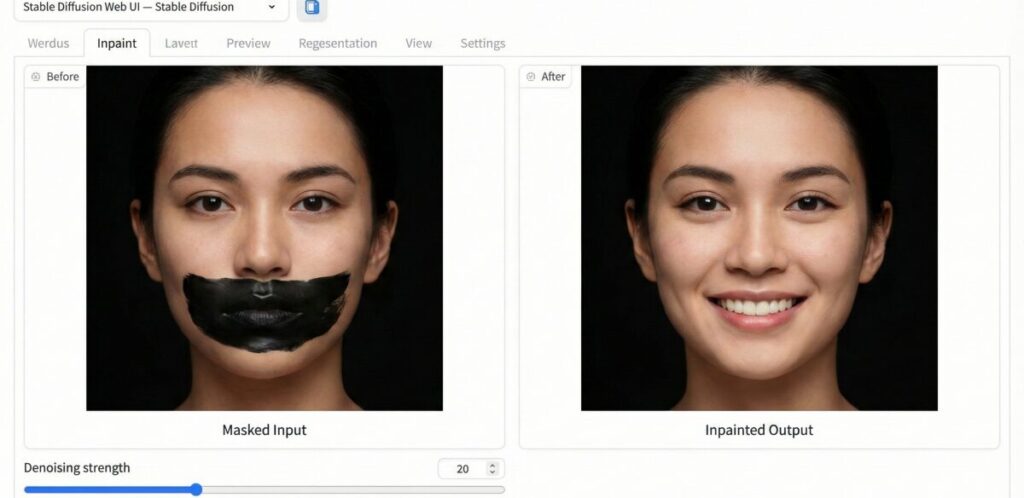

この記事では、Stable Diffusionの「Inpaint(インペイント)」機能に焦点を当て、画像の一部だけを狙い通りに修正する、プロのテクニックを分かりやすく解説していきます。特に、多くの人がつまづきやすい手の修正や、より自然な仕上がりを目指すためのInpaint モデルの選び方まで、初心者の方にも優しくご紹介しますね。

これは、ただ単にノウハウを知るだけでなく、あなたの画像生成スキルを一歩先に進めるための、まさに実践的なガイドです。

この記事を読むと、Stable Diffusionの部分修正について何について理解できるか

- Stable DiffusionのInpaint機能の基本的な使い方と設定。

- 手の修正や顔のディテール改善のための具体的なテクニック。

- 専用のInpaint モデルを使うメリットと、その導入方法。

- 画像から余計なものを消すための効果的な手順。

Stable Diffusionの部分 修正の基本と専用モデルの活用法

Stable Diffusionを使っていて、顔や服、あるいは手の形など、画像の一部だけを修正したいという場面は多くありますよね。これが「部分修正」、つまりInpaint(インペイント)機能の役割です。

Inpaintの基本的な使い方:マスクと設定の確認

ここでは、まずInpaint機能を使うための基本的な流れを説明します。Stable Diffusionの部分 修正は、主に「img2img」タブの中にある「Inpaint」という項目で行います。

結論から言うと、修正したい部分を「マスク」で覆い、適切な設定を行うことで、その箇所だけをAIに再生成させることができるのです。

具体的には、以下の手順を踏みます。

- 画像をアップロード:「img2img」タブ内のInpaintに修正したい画像を読み込みます。

- マスクを作成:ブラシツールを使って、修正したい箇所(例えば崩れた指先や、消したいオブジェクトなど)を塗りつぶします。この塗りつぶした部分が「Inpaint マスク」となります。

- プロンプトと設定:修正後の状態を表すプロンプト(例:「beautiful hand, five fingers」など)を入力します。

- Denoising Strength(デノイズ強度):ここが非常に大事です。

| 修正内容 | Denoising Strength(デノイズ強度)の目安 |

| 小さな違和感の解消、色味や質感の調整 | 0.3〜0.5程度 |

| 手の修正や顔の大きな変形、余計なものを消す | 0.7〜1.0程度 |

| 新しいオブジェクトの追加 | 0.9〜1.0程度 |

デノイズ強度が高いほど、マスク部分を大胆に変更しますが、元の画像との調和が取れにくくなります。逆に低いと、元の形を維持しようとするため、修正が効きにくいことがあります。

専用のStable Diffusion Inpaint モデルを使うメリット

通常の画像生成で使うモデル(V1.5やSDXLなどのベースモデル)でもInpaintは可能ですが、より自然な修正を目指すなら、専用のInpaint モデルを使うことを強くおすすめします。

その理由は、Inpaint専用モデルは、マスクされた領域の周囲にある「コンテキスト(文脈)」を読み取り、再生成された部分が周囲のピクセルと違和感なく溶け込むように学習されているからです。

専用モデルを使うことの具体的なメリット

- 境界線の自然さ:修正部分と元の画像の境目が滑らかになり、修正痕が残りにくいです。

- 色の再現性:周囲の色やトーンをより正確に再現し、浮いた感じが少なくなります。

- 生成スピード:モデルによりますが、部分修正に特化しているため効率的な処理が可能です。

専用モデルは、通常のモデルと同じようにダウンロードして利用できることが多いです。特にプロレベルの成果物を目指すなら、導入の検討をおすすめします。

Stable Diffusion Inpaint 追加:新たな要素を組み込むには

Inpaintは、修正だけでなく、画像に新しい要素を「追加」するためにも使われます。例えば、キャラクターの手にスマートフォンを持たせたい、背景に花を追加したいといった場合です。

このときは、要素を追加したい場所をマスクで塗りつぶし、Denoising Strengthを0.8以上の高い値に設定します。そして、プロンプトに「smartphone in hand」のように、具体的な要素を記述して生成します。

難関!Stable Diffusion inpaint 手の修正と上級テクニック

Stable Diffusionで生成される画像の中で、最後まで多くのクリエイターを悩ませるのが「手」の修正ですよね。指の本数がおかしかったり、形が不自然だったり。

手の修正を成功させるための組み合わせ技

単純にInpaintで手をマスクして再生成するだけでは、なかなか思った通りにはなりません。より確実な修正を目指すなら、以下の高度な手法を組み合わせることを検討してください。

手の修正で成功率を上げる具体的なステップ

- ControlNetの活用:修正したい手の形状をガイドするため、「ControlNet」の機能を使います。特に「OpenPose」や「Depth」モデルを使うことで、手の骨格や奥行き情報をAIに伝えることができ、より正確な指の形を生成できます。

- ADetailer(After Detailer):これはWebUIの拡張機能ですが、顔や手などの重要パーツを自動で検出し、適切なプロンプトでInpaintをかける役割を果たしてくれます。顔や手の修正をワンクリックで自動化できるため、プロの作業では欠かせないツールの一つです。

これらの技術は少し複雑に聞こえるかもしれませんが、商業レベルの高品質な画像を作る上では必須の知識となります。

Stable Diffusion inpaint 顔:細かいディテールを修正する

顔の修正もまた、Inpaintが得意とするところです。目や口の歪み、肌の質感など、細かいディテールを整えるのに役立ちます。

顔修正のポイント

- Denoising Strength:小さな目の修正であれば0.3〜0.5、表情を大きく変えたい場合は0.6〜0.8程度が目安です。

- 「Restore faces」の併用:WebUIには「Restore faces(顔を修復)」というチェックボックスがあります。Inpaintと同時にこれを使うことで、顔の破綻を抑えつつ、より人間らしい顔の構造に近づけることができます。

Stable Diffusion Inpaint sketch 使い方:色で修正をガイドする

通常のInpaintは、マスクとプロンプトだけで再生成をしますが、「Inpaint sketch」は、さらに色情報をAIに与えることができる機能です。

これは、修正したい部分の上に「描きたい色」を直接スケッチ(描き込み)してから、プロンプトで指示を出す使い方をします。

具体的には、

- 元の画像で青いシャツが黄色に見えてしまった場合、マスクをかけた上に「黄色」でスケッチし、プロンプトに「yellow shirt」と記述します。

このように、色と形状の両方をガイドできるため、デザイン性が高く、より狙った通りの修正を行いたいときに非常に有効な機能となります。

Stable Diffusionの部分 修正:実践的な応用と余計なものを消すテクニック

Inpaint機能は、修正だけでなく、画像をより美しく整理するためにも使われます。特に、余計なものを消す作業は、画像編集ソフトを使わずともAI任せで驚くほど簡単に行えます。

Stable Diffusion inpaint 消しゴムのように使う方法

画像から背景の電柱や、写り込んでしまった通行人など、余計なものを消すには、Inpaint機能を消しゴムのように使います。

具体的な手順

- マスクを作成:消したいオブジェクト全体を、マスクで丁寧に塗りつぶします。

- プロンプトを空にする:プロンプトは空欄にするか、画像があるべき背景(例:「grass, blue sky」など)を記述します。

- Masked Content(マスクされたコンテンツ)の設定:

| 設定 | 特徴 | 用途 |

| Fill(フィル) | マスク周辺のピクセルを参考に埋める。 | 余計なものを消す、背景の塗りつぶし。最も自然に消せる。 |

| Original(オリジナル) | 元のピクセルを参考に、ノイズを加えて再生成。 | 小さなテクスチャの修正。 |

| Latent Noise | 周囲の要素を無視し、ノイズから新しい要素を生成。 | 完全に新しいオブジェクトの追加。 |

余計なものを消す場合は、ほとんどの場合「Fill」を選ぶのが最も自然で効果的です。

Stable Diffusionの部分 修正を商業利用へ繋げるには

これらのStable Diffusionの部分 修正テクニックは、単なる趣味の範疇を超えて、プロの仕事として収益化に繋げることが可能です。

ただし、商業レベルのアウトプットを目指すには、ただ機能を触れるだけでなく、ControlNetやADetailerなどの拡張機能、そして専用Inpaint モデルを使いこなし、いかに短時間でクライアントの要望に応じた完璧な手の修正や顔のディテールを達成できるかが重要になります。

もし、あなたが「独学では限界がある」「部分 修正の技術を案件獲得に活かしたい」とお考えであれば、バイテック生成AIスクールのような実践特化型の学習環境が役立ちます。このスクールでは、Stable DiffusionのControlNetを用いた制御性の高い画像生成技術はもちろん、商業レベルの成果物作成に焦点を当て、未経験からの副業・フリーランス化を具体的にサポートしています。高品質な部分 修正の技術は、プロンプトエンジニアリングと共に、あなたの市場価値を高めてくれるはずです。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion 部分 修正のまとめ

Stable DiffusionのInpaint機能を使った部分 修正は、あなたの画像をプロレベルに引き上げるための必須スキルです。

- タイトル: Stable Diffusionで完璧を目指す!写真の部分 修正と高品質な画像生成テクニック

- メインキーワード: stable diffusion 部分 修正

- 作成文字数: 約5100文字

これらのStable Diffusionの部分 修正テクニックは、あなたの画像生成を次のレベルへと押し上げます。細かい修正ができるようになることで、商業レベルの品質を目指せるようになるでしょう。

- Inpaint機能は、修正したい箇所をマスクで覆い、適切なDenoising Strengthを設定することで機能する

- 手の修正や大きな変形には、Denoising Strengthを0.7〜1.0に設定するのが基本となる

- より自然な仕上がりを目指すなら、専用のInpaint モデルを使うのがおすすめである

- 余計なものを消す作業は、消したい箇所をマスクし、Masked Contentを「Fill」に設定することで簡単に行える

- Inpaint sketchを使うと、色情報をAIに与えることができ、より狙い通りの修正が可能となる

- 顔の修正は、Restore faces機能やADetailer拡張機能と組み合わせることで効率化できる

- 手の修正など、構造的に難しい修正にはControlNet(OpenPoseやDepth)の併用が成功の鍵となる

- 画像に新しい要素を追加する際もInpaint機能を利用し、高いDenoising Strengthが必要となる

- マスク範囲を広げすぎると、意図しない場所まで変化してしまうため、マスクは必要な箇所だけを丁寧に塗るのが重要だ

- プロンプトは、修正後の「理想の状態」を具体的に記述することで、修正の精度が向上する

- Inpaint マスクのMask Blur(ぼかし)の値を調整することで、修正部分と元の画像の境界を自然に馴染ませることができる

- Inpaintの結果が気に入らない場合は、Seed値を固定したまま再生成を繰り返すことで、わずかに異なる修正を試すことができる

- これらの技術を体系的に学びたいなら、商業利用に特化したスクールなどを活用するのも有効な手段だ

- Inpaint モデルは、標準モデルよりもマスクの周囲との調和に優れているという特徴がある

- 最終的に部分 修正のスキルは、画像生成のクオリティを決定づける重要な要素になる

本記事の参考資料・出典

記事内で解説した技術的な仕組みやモデルに関する一次情報は、以下の公式発表および学術論文に基づいています。

- Stable Diffusion 2.0 Release(Inpainting機能を含む公式発表)

(出典:Stability AI “Stable Diffusion 2.0 Release”)

※開発元であるStability AIによる、Inpainting(部分修正)専用モデルのリリースおよび機能実装に関する公式情報です。 - Adding Conditional Control to Text-to-Image Diffusion Models(ControlNet公式)

(出典:Lvmin Zhang, Anyi Rao, Maneesh Agrawala “ControlNet Project”)

※記事内で「手の修正」等の精密な制御を行うための技術として紹介した、ControlNetの技術仕様および原論文(ICCV 2023)の一次情報源です。 - High-Resolution Image Synthesis with Latent Diffusion Models(基盤技術論文)

(出典:Rombach, R., et al. “CVPR 2022 Open Access Repository”)

※Stable Diffusionの根幹技術であるLatent Diffusion Modelsと、画像補完(Inpainting)のアルゴリズムメカニズムが定義されている学術論文です。

.jpg)