最近、SNSなどで「これ本当にAIなの?」と驚くような、写真そっくりの画像を見かけることって増えましたよね。「私もあんなリアルな日本人女性を作ってみたい!」と思ってStable Diffusionを始めたものの、なんとなくイラストっぽさが抜けなくて悩んでいる方も多いのではないでしょうか?

実は、写真のような実写画像を生成するには、いくつかの「決まったコツ」があるんです。モデル選びからプロンプトの呪文、そしてちょっとした設定の工夫まで。これらを知っているかどうかで、仕上がりには天と地ほどの差が出ます。

この記事では、初心者の方でも迷わずリアルな美女が作れるように、私の経験を元に優しく解説していきますね。

この記事を読むと、以下のことが理解できるようになります。

- リアルな日本人を生成するのに最適なモデルと入手方法

- 「写真のような」質感を実現するための具体的なプロンプト(呪文)

- 肌のきめ細やかさや光の当たり方を調整するLoRAや設定のコツ

- イラストを実写化する際や、失敗を防ぐためのテクニック

Stable Diffusionで実写プロンプトとモデルを使いこなす準備

まずは、リアルな画像を生成するための土台作りから始めましょう。「プロンプトさえ良ければいい」と思われがちですが、実は一番大事なのは「モデル(Checkpoint)」の選び方なんです。ここを間違えると、いくら良い呪文を唱えてもアニメ調の絵しか出てきません。

リアルな日本人が作れる実写モデルの選び方

実写系、特に私たちにとって親しみのある「リアルな日本人」を作りたい場合、海外のモデルそのままでは彫りが深すぎることがあります。そこで、日本人の生成に特化したモデルを選ぶのが近道です。

私が普段使っていて、初心者の方にも絶対おすすめできるモデルをいくつか紹介しますね。これらは「Civitai」などのサイトからダウンロードできます。

| モデル名 | 特徴 | おすすめの理由 |

| Beautiful Realistic Asians (BRA) | アジア系実写モデルの金字塔 | 肌の質感や顔立ちが非常にリアルで、初心者でも失敗が少ないです。 |

| yayoi_mix | 日本人女性に特化 | アイドルのような可愛らしさとリアルのバランスが絶妙です。 |

| ChilloutMix | 実写系の火付け役 | 少し古いですが、依然として根強い人気があり、LoRAとの相性が抜群です。 |

| Juggernaut XL | SDXLベースの超高画質 | 背景や空気感まで含めて「写真そのもの」を作りたいならこれ。 |

これらを導入するだけで、出力される画像が一気に「写真」に近づきますよ。

写真のような質感を作るための設定

モデルを決めたら、次は生成時の設定(Settings)です。「なんだか難しそう…」と構えなくて大丈夫。ここだけ押さえておけばOK、というポイントは意外と少ないんです。

特に重要なのが「VAE」です。これは画像の「色味」を整えるフィルターのようなもの。実写系モデルの中にはVAEが内蔵されているものもありますが、色がくすんでしまう場合はvae-ft-mse-840000などを使うと、パッと明るく鮮やかな写真になります。

また、画像のサイズも重要です。実写の人物、特に全身を生成する場合は、縦長のサイズ(512×768など)に設定しましょう。横長だと、AIが混乱して「顔が2つある」ような失敗作ができやすくなってしまうからです。

イラストを実写化する際に知っておくべきこと

「手描きのイラストを実写化したい」というのもよくある要望ですよね。この場合、テキストから生成する(txt2img)だけでなく、元画像を参考にする(img2img)という機能を使います。

ただ、ここで一つ壁があります。単に変換するだけだと、ポーズが変わってしまったり、顔が別人になったりしやすいんです。そこで、プロの現場では「ControlNet」という技術を使ってポーズをガチガチに固定したりします。

趣味で楽しむ分にはimg2imgで十分ですが、もし将来的に「生成AIを仕事にしたい」「思い通りの構図で広告バナーを作りたい」と考えているなら、基礎からしっかり学んでみるのも手です。例えば、バイテック生成AIスクールのような実践型のスクールでは、こういったControlNetを使った商業レベルの画像生成技術まで教えてくれるので、独学で躓いている方には良い選択肢になるかもしれません。

Stable Diffusionの実写プロンプトでリアルな日本人を作るコツ

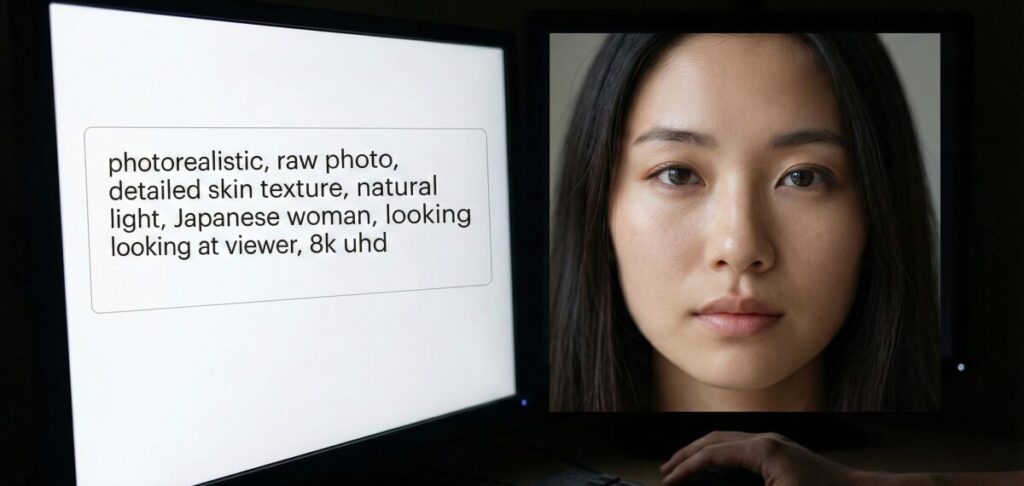

土台ができたら、いよいよ「プロンプト(呪文)」の入力です。AIに「これは絵じゃなくて写真だよ!」と強く認識させることが、成功のカギになります。

肌の質感を極めるプロンプトの書き方

実写に見えるかどうかは、「肌の質感」で決まると言っても過言ではありません。つるつる過ぎるとマネキンのようになってしまうので、あえて「毛穴」や「産毛」といった情報を足してあげると、グッとリアリティが増します。

以下の単語をプロンプトの最初の方に入れてみてください。

- Best quality, masterpiece, ultra high res (まずは高画質指定)

- Photorealistic, raw photo, 8k (写真であることを強調)

- Detailed skin, skin texture, pore (肌のキメや毛穴を描写)

このように言うと「毛穴なんて描いて大丈夫?」と心配になるかもしれませんが、AIにおいてはこれが「人間らしさ」を表現する重要なスパイスになるんです。

光とアングルを操る実写のような指定

次に大切なのが「ライティング」と「カメラ」です。プロのカメラマンが撮影したような雰囲気を出すために、光の当たり方を指定しましょう。

例えば、ふんわりとした優しい写真にしたいなら soft lighting や cinematic lighting が効果的です。逆に、屋外の自然な感じを出したいなら natural light や sunlight を入れます。

また、カメラのアングルも重要です。

looking at viewer(カメラ目線)depth of field(背景をぼかして被写体を際立たせる)

これらを入れるだけで、スマホで適当に撮った写真ではなく、「一眼レフで撮ったポートレート」のような仕上がりになりますよ。

クオリティを底上げするLoRAの使い方

「モデルもプロンプトも合っているのに、あと一歩何かが足りない…」そんな時に役立つのが「LoRA」です。これはモデルに追加する「トッピング」のようなもので、特定の画風や顔立ちを強化できます。

実写系で特におすすめなのが、JapaneseDollLikeness や KoreanDollLikeness です。これらを少し混ぜる(Weightを0.3〜0.5くらいにする)だけで、アジア人特有の可愛い顔立ちが一瞬で生成されます。

また、Add More Details というLoRAも万能です。これを加えると、服のシワや背景の書き込みが緻密になり、画面全体の情報量が増えて一気にリッチな印象になります。ただし、入れすぎると書き込み過多で怖くなるので、控えめに使うのがコツです。

失敗しないためのネガティブプロンプト

最後に、忘れてはいけないのが「ネガティブプロンプト」です。「これは描かないで!」という指示ですね。実写を目指すなら、以下の要素を必ず否定しておきましょう。

painting, sketch, cartoon, anime(絵画やアニメ要素を排除)low quality, worst quality(低画質を排除)3d, render, doll(3DCGや人形っぽさを排除)

これを入れておかないと、AIは「もしかしてこれ、リアルな絵画を描きたいのかな?」と迷ってしまい、中途半端な画像が出てきてしまいます。実写化において、ネガティブプロンプトはポジティブプロンプトと同じくらい重要なんです。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusionで実写を極めるためのまとめ

ここまで、Stable Diffusionでリアルな実写画像を生成するためのテクニックをお話ししてきました。最初は難しく感じるかもしれませんが、モデルを選んで、光と質感を指定するプロンプトを入れるという「型」さえ覚えてしまえば、誰でもプロ級の写真が作れるようになります。

最後に、今回のポイントをまとめておきますね。

- 実写化の基本はモデル選びから。BRAやyayoi_mixなどがおすすめである

- モデルは日本人生成に特化したものを選ぶと失敗が少ない

- VAEを設定して色味のくすみを防ぐことが重要だ

- 画像のサイズは縦長(512×768など)に設定すると全身がきれいに映る

- プロンプトにはphotorealisticやraw photoを必ず入れる

- detailed skinやporeで肌の質感を指定するとリアリティが増す

- soft lightingなどのライティング指定でプロっぽい写真になる

- カメラ目線や背景ぼかし(depth of field)も有効な呪文である

- LoRAを使うと、顔の系統や書き込み量を微調整できる

- JapaneseDollLikenessはアジア系の顔立ちを作るのに最適だ

- Add More Detailsで画像の密度を上げることができる

- ネガティブプロンプトでanimeやpaintingをしっかり排除する

- イラストの実写化にはimg2imgを使用する

- ポーズ固定などの高度な編集にはControlNetの習得が必要である

- 商用利用を目指すならスクールなどで体系的に学ぶのも近道だ

ぜひ、これらのテクニックを使って、あなただけの最高の「一枚」を作ってみてくださいね!

参考資料・出典

記事内で紹介した技術やモデルの信頼性・根拠となる一次情報源は以下の通りです。

- Stable Diffusion 開発元・公式情報

(出典:Stability AI『Stable Diffusion 公式サイト』)

※生成AIの基盤モデル「Stable Diffusion」を開発・提供しているStability AI社の公式ページです。 - 画像生成技術の学術的根拠(原論文)

(出典:Ludwig Maximilian University of Munichほか『High-Resolution Image Synthesis with Latent Diffusion Models』)

※Stable Diffusionの技術的基礎となっている「潜在拡散モデル(Latent Diffusion Models)」に関するCVPR 2022発表の学術論文です。 - モデルおよびデータセットの技術基盤

(出典:Hugging Face『Stable Diffusion (Diffusers Library)』)

※世界最大級の機械学習モデル・データセット共有プラットフォームであり、本記事で解説した実写モデル等の技術仕様やホスティングの一次情報源です。

.jpg)