「奇跡的に可愛い女の子が生成できた!でも、二度と同じ顔が出せない……」

Stable Diffusionを触り始めたばかりの頃、誰もが一度はこの壁にぶつかりますよね。

プロンプトを少し変えただけで、まるで別人のような顔になってしまい、理想のキャラクターで作品を作り続けるのを諦めてしまうことも少なくありません。

でも、安心してください。

現在はAI技術の進歩により、完全に同じ顔や雰囲気を維持したまま、自由自在にポーズや服装を変える方法が確立されています。

Seed値の固定といった基本的なテクニックから、LoRAやControlNetといった拡張機能を使った本格的な手法まで、実は「同じキャラ」を出すための選択肢はたくさんあるのです。

この記事では、初心者の方でも迷わず実践できるように、キャラクターを固定するテクニックを分かりやすく解説していきます。

この記事を読むと、以下の4点について理解できます。

- Seed値やプロンプトだけでキャラクターを固定する際の限界とコツ

- ControlNetやIP-Adapterを使って、同じ顔で違うポーズを作る方法

- LoRAを活用して、特定のオリジナルキャラや版権キャラ風の絵を安定させる手順

- 服装や背景が変わっても、顔だけは崩さないための具体的な設定方法

Stable Diffusionで同じキャラを出す基本とコツ

まず最初は、特別な追加ファイルなどを使わずに、Stable Diffusionの基本機能だけでどこまで「同じキャラ」に近づけるか、その仕組みとコツについてお話しします。

多くの人が最初に試す「Seed値」ですが、実はこれだけでは不十分なことが多いのです。

ここでは、なぜ同じ画像にならないのかという疑問を解消しつつ、プロンプトでの工夫や、顔だけを修正する技術について見ていきましょう。

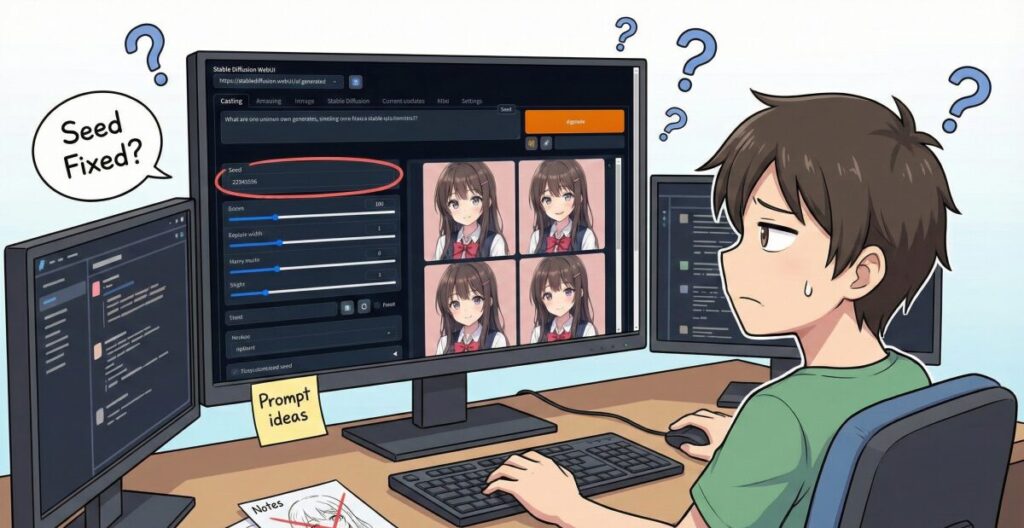

Seed値固定だけでは不十分?「同じ画像にならない」悩み

「Seed(シード)値を固定すれば同じ絵が出る」と教わった方も多いかもしれません。

確かに、プロンプト(呪文)や設定が完全に一言一句同じであれば、Seed値を固定することで全く同じ画像を再生成することは可能です。

しかし、私たちがやりたいのは「同じ絵」を出すことではなく、「同じキャラで違うシチュエーション」を作ることですよね。

例えば、「公園に立っている」を「カフェで座っている」に変えるためにプロンプトを書き換えると、Seed値が同じでも、AIは計算結果を大きく変えてしまいます。

その結果、顔のパーツや髪型まで微妙に変化してしまい、「誰これ?」という状態になってしまうのです。

ただ、Seed値を固定することに意味がないわけではありません。

ベースとなる雰囲気や構図の乱数(ランダム要素)を固定する役割はあるので、プロンプトの変更が軽微であれば、似たような雰囲気を保ちやすくなります。

まずは「Seed値固定は万能ではない」と理解した上で、次のステップへ進むのが重要です。

版権キャラや有名人のプロンプトを活用する仕組み

キャラクターを固定する一番シンプルな方法は、AIがすでに知っている「概念」を利用することです。

Stable Diffusionのモデルは、インターネット上の膨大な画像で学習しているため、有名なアニメの版権キャラや、世界的な有名人の名前をプロンプトに入れると、非常に安定して同じ顔が出力されます。

例えば、プロンプトに具体的なキャラクター名や、特徴的な髪型・目の色を詳細に記述することで、AIに対して「この顔を描いて!」と強く指定することができます。

これを応用して、複数の有名人の名前をミックス(例:actress A and actress B)したり、重み付けを変えたりすることで、「特定の誰かではないけれど、常に同じ顔をしたオリジナルキャラ」のプロンプトを作ることも可能です。

この手法のメリットは、追加のツールがいらないこと。

デメリットは、どうしても既存のキャラクターに似てしまうため、オリジナリティを出しにくい点です。

もし特定の版権キャラ風にしたい場合は有効ですが、完全に自分のオリジナルキャラを作りたい場合は、後述するControlNetなどの技術が必要になります。

顔だけ変える「Inpainting」という選択肢

「全身の構図やポーズは完璧なのに、顔だけが崩れてしまった……」

そんな時に役立つのが、Inpainting(インペインティング)という機能です。

これは、画像の修正したい部分だけをマスク(塗りつぶし)して、そこだけをAIに描き直させる技術です。

Inpaintingを使えば、体のポーズや服装、背景はそのまま維持しつつ、顔の部分だけを何度も再生成して、理想の「いつもの顔」が出るまでガチャ(試行)を繰り返すことができます。

また、Denoising strength(ノイズ除去強度)という数値を調整することで、「元の顔の面影を残しつつ綺麗にする」のか、「全く別の顔に書き換えるのか」をコントロールすることも可能です。

手間はかかりますが、一枚絵としてのクオリティを高めるには必須のテクニックと言えるでしょう。

複数枚生成して選別する重要性

いくら高度な設定をしても、AIは確率で絵を描画するため、100発100中で同じ顔が出るわけではありません。

プロのAI術師であっても、1枚の神イラストを作るために、裏では何十枚、時には何百枚もの失敗作を生成しています。

「Stable Diffusion 同じキャラ 複数」で検索する人が多いように、数を出すことは大前提なのです。

一度お気に入りの設定が見つかったら、Batch count(生成回数)を増やして、一気に10枚、20枚と出力してみましょう。

その中から、「この角度ならこのキャラに見える!」という奇跡の一枚を選び出す作業も、AIアート制作の醍醐味の一つです。

また、気に入った画像生成AIのスキルをただの趣味で終わらせず、仕事に繋げたいと考える方もいるかもしれません。

例えば、「バイテック生成AIスクール」のような、実務特化型のスクールで学ぶのも一つの手です。

ここでは、趣味レベルを超えて、企業案件やクラウドソーシングで稼ぐための「品質の高い画像生成」や「一貫性のあるキャラクター制作」を体系的に学べます。

独学で何百枚も生成して試行錯誤する時間を、プロのノウハウで短縮できるのは大きな魅力ですよね。

Stable Diffusionで同じキャラを本格的に固定する高度な技術

ここからは、さらに一歩進んだテクニックを紹介します。

「なんとなく似ている」レベルではなく、「完全に同一人物」として認識されるレベルを目指すなら、拡張機能の導入が欠かせません。

特に「LoRA」や「ControlNet」は、現在の画像生成において必須級のツールです。

これらを使いこなせれば、漫画や写真集のように、同じキャラクターでストーリーを展開させることも夢ではありませんよ。

オリジナルキャラをLoRAで学習させる

「Stable Diffusion 同じキャラ LoRA」というキーワードで情報を探しているなら、これが最強の解決策です。

LoRA(Low-Rank Adaptation)とは、既存のモデルに追加学習データを読み込ませる仕組みのことです。

簡単に言うと、AIに「これが私の描きたいキャラクター(Aちゃん)だよ」という専用の参考書を渡すようなイメージです。

自分で用意したキャラクターの画像(15〜20枚程度)を学習させてLoRAファイルを作成し、それをプロンプトと一緒に読み込ませることで、どんなプロンプトを入力しても、AIはそのキャラクターの特徴(顔、髪型、雰囲気)を優先して描画してくれるようになります。

| 手法 | 固定力 | 手間 | 自由度 |

| プロンプト指定 | △ | 少 | 高 |

| Seed値固定 | △ | 極少 | 低 |

| ControlNet | 〇 | 中 | 高 |

| LoRA | ◎ | 大 | 高 |

表のように、LoRAは準備に手間(学習用の画像収集やPCスペック)が必要ですが、一度作ってしまえば「同じキャラ」の再現度は圧倒的です。

特定の服装や画風を学習させることもできるため、自分だけのオリジナルブランドを確立したい人には最適です。

ControlNetを使って同じ顔で違うポーズを作る

学習まではしたくないけれど、手軽にキャラを固定したい。

そんな時に役立つのが、ControlNet(コントロールネット)の「IP-Adapter」や「Reference」という機能です。

これらは、プロンプトだけでなく「参照画像」をAIに見せることで、「この画像の顔に寄せて!」と指示出しができる機能です。

特に「IP-Adapter-FaceID」などは非常に強力です。

元となるキャラクターの画像を一枚ControlNetにセットし、プロンプトで「走っている」「ご飯を食べている」と指示すれば、顔の特徴は元画像のまま、指定したポーズをとらせることができます。

「Stable Diffusion 同じ顔 違うポーズ」を実現するには、このControlNetの使い方がカギを握ります。

LoRAを作るほど画像枚数がない場合でも、たった一枚のベストショットがあれば、それを基準に量産体制に入れるのが最大のメリットです。

同じ服装を維持するための指定テクニック

顔と同じくらい難しいのが「服装の固定」です。

AIは「白いドレス」と言われても、毎回違うデザインのドレスを描いてしまいます。

「Stable Diffusion 同じ服装」を維持するためには、以下の3つのアプローチが有効です。

- プロンプトを詳細にする: 単に

school uniformとするのではなく、white shirt, blue necktie, navy blazer, plaid skirtのように、パーツごとに細かく指定します。 - 服装のLoRAを使う: 既存の配布されている「特定のコスチュームLoRA」を使用するか、自分のキャラに着せたい服だけを学習させたLoRAを作ります。

- Inpaintingで服だけ書き換えない: 顔や背景を変えたい場合、服の部分をマスクせずに固定しておけば、服のデザインは変わりません。

これらを組み合わせることで、漫画のキャラクターのように「いつもの服」を着た状態をキープしやすくなります。

読者が気になる「AIっぽさ」を消す工夫

最後に、同じキャラを作り続ける上で壁となる「AIっぽさ」についてです。

AI生成画像は、肌がツルツルしすぎたり、表情が乏しかったりと、特有のクセが出ることがあります。

同じキャラを連続して生成すると、この「AI特有の無機質な感じ」が目立ってしまいがちです。

これを避けるためには、プロンプトにskin texture(肌の質感)やdetailed eyes(詳細な目)といった品質向上タグを入れることや、アップスケーラー(高画質化機能)を使って書き込み量を増やすことが有効です。

また、照明(ライティング)の指定を変えるだけでも、ガラッと印象が変わり、自然な写真やイラストに見えるようになります。

こうした「実務レベルで通用する品質」を突き詰めたい場合、先ほど紹介した「バイテック生成AIスクール」のような環境で、プロのフィードバックを受けるのも良いでしょう。

独学では気づけない「AIっぽさを消す微調整」や「クライアントに喜ばれる納品データの作り方」など、一歩先のスキルが身につきます。

同じキャラを自在に操れるようになれば、LINEスタンプの販売や、ゲームの立ち絵制作など、活躍の場は一気に広がりますよ。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusionで同じキャラを作るまとめ

ここまで、Stable Diffusionで同じキャラクターを一貫して生成するための技術を紹介してきました。

最後に、要点をまとめます。

- Seed値の固定だけでは、ポーズ変更時に顔が変わるのを防げない。

- プロンプトに詳細な特徴タグを入れるのが固定の第一歩である。

- 版権キャラや有名人の名前を混ぜることで顔立ちを安定させられる。

- Inpaintingを使えば、構図を維持したまま顔だけをガチャできる。

- 同じ顔で違うポーズを作るならControlNet(IP-Adapter)が必須である。

- LoRA学習は手間がかかるが、キャラ固定における最強の手段である。

- LoRAを作成するには、15〜20枚程度の学習用画像が必要となる。

- IP-Adapterなら、1枚の画像を参照して似た顔を量産可能である。

- 同じ服装にするには、色や形状を細かくプロンプトで指定する。

- 服装専用のLoRAを使うことで、デザインのブレを最小限にできる。

- 複数枚生成(Batch count)して、奇跡の一枚を選ぶのが基本である。

- AI特有のツルツル感を消すには、質感プロンプトやアップスケールが有効。

- 高画質化と修正を繰り返すことで、実務レベルの品質に近づく。

- 一貫性のある画像生成は、漫画やゲーム素材制作への応用が可能だ。

- 確実なスキル習得には、専門スクールでの学習も近道である。

本記事の執筆にあたっての参考資料・出典

記事内で解説した技術や権利関係に関する信頼性を担保するため、以下の一次情報源および公的機関の情報を参照しています。

- Stable Diffusion 開発元

生成AIの基盤モデルに関する公式情報は、開発元の発表に基づいています。

Stability AI 公式サイト - ControlNet 技術論文(arXiv)

同じキャラクターの姿勢制御に使用する「ControlNet」の技術的仕組みは、以下の学術論文を論拠としています。

Adding Conditional Control to Text-to-Image Diffusion Models (Lvmin Zhang, et al. 2023) - AI生成物と著作権に関する法的見解

版権キャラクターや生成物の権利関係については、文化庁が公表している指針に基づき、法令遵守を推奨しています。

文化庁『AIと著作権』に関する取り組み・資料

.jpg)