- 「せっかくStable Diffusionを導入したのに、何度生成しても同じような顔の女性ばかり出てくる…」

- 「モデルを変えても、やっぱりどこか似たような雰囲気になってしまう」

あなたは今、こんな悩みを抱えていませんか?

AI画像生成を始めたばかりの頃は、誰もがこの「同じ顔ばかり問題」に直面します。実はこれ、AIの仕様や設定のコツさえ掴んでしまえば、簡単に解決できるんです。むしろ、意図的に違う顔を作ったり、逆に特定の顔を固定したりすることも自由自在になりますよ。

この記事では、Stable Diffusionで違う顔を出すための具体的なテクニックから、逆に顔を固定する方法、さらには実務で使えるレベルのコントロール術まで、初心者の方にもわかりやすく解説していきます。

この記事を読むと、Stable Diffusionで「同じ顔ばかり」と検索している人は以下の4点について理解できます。

- なぜAIイラストは放っておくと「同じ顔」になりやすいのか、その根本的な原因

- シード値やプロンプトを調整して、バリエーション豊かな「違う顔」を作る方法

- ADetailerやLoRAを使って、顔のパーツや画風を思い通りに制御する技術

- 生成AIを趣味で終わらせず、仕事に繋げるための学習ルート

Stable Diffusionで同じ顔ばかり生成される原因と基本の対策

まずは、なぜあなたの生成する画像がStable Diffusionで同じ顔ばかりになってしまうのか、その原因を紐解いていきましょう。AIが画像を生成する仕組みを少しだけ理解するだけで、脱マンネリ化への第一歩が踏み出せます。

AIイラスト 同じ顔 ばかりになるのはなぜ?

結論から言うと、「指定が曖昧だと、AIは学習データの中で最も一般的な『正解』を出そうとするから」です。

Stable Diffusionのモデル(Checkpoint)は、膨大な数の画像を学習しています。しかし、プロンプト(呪文)で細かい特徴を指定しない場合、そのモデルが「美少女」や「女性」という言葉に対して持っている「平均的なイメージ」を出力しがちです。これが、AIイラストで同じ顔ばかりになってしまう最大の理由と言えるでしょう。

また、特定のモデルは特定の顔立ちに偏っていることがあります。例えば、アジア系の実写モデルを使えば、指示をしなくても「K-POPアイドルのような整った顔」になりやすいですし、アニメ系モデルなら「目が大きな特定のアニメ顔」になりがちです。これはAIの「手癖」のようなものだと考えてください。

シード値(Seed)を固定していないか確認しよう

Stable Diffusionで同じ画像ばかり生成される時、一番最初に疑うべきは「シード値(Seed)」の設定です。

シード値とは、画像を生成する際の「乱数の種」のこと。この数字が同じであれば、同じプロンプトと設定からは全く同じ画像が生成されます。

多くの生成ツールでは、デフォルトでSeedが「-1(ランダム)」になっていますが、もし以前に良い画像ができたからといって、その時のSeed値を固定したままにしていませんか?

「Generate」ボタンの近くにあるサイコロのマークを押して、Seedを「-1」に戻してあげましょう。これだけで、毎回違う構図、違う顔が生成されるようになります。

| 設定項目 | 状態 | 結果 |

| Seed値 | 固定(例:123456) | 何度押しても同じ画像・同じ顔が出る |

| Seed値 | ランダム(-1) | 押すたびに構図や顔立ちが変わる |

Stable diffusion 毎回 同じ 顔にならないためのプロンプト術

シード値をランダムにしても「やっぱりStable diffusionで毎回同じ顔になる…」という場合は、プロンプト(呪文)の出番です。

単に 1girl, cute とだけ入力していませんか?

これでは情報量が少なすぎて、AIはモデルの「デフォルト顔」を出してしまいます。違う顔を出したいなら、顔の特徴を具体的に指定してあげましょう。

例えば、以下のように要素を足してみてください。

- 髪型・髪色を変える:

short hair,long wavy hair,blonde hair,black hair - 目の色・形を変える:

blue eyes,tsurime(つり目),tareme(たれ目) - 年齢層を変える:

mature female,child,20 years old - 国籍や雰囲気を変える:

Japanese,American,Nordic,tanned skin

このように詳細な指示を与えることで、AIは「いつもの顔」ではなく、あなたの指示に従った「新しい顔」を描こうと努力してくれます。

モデル(Checkpoint)の特性を知って違う顔を作る

プロンプトを工夫しても限界がある場合は、思い切ってモデル(Checkpoint)を変更してみましょう。これがStable Diffusionで違う顔を作る最も手っ取り早い方法の一つです。

モデルにはそれぞれ「得意な顔」があります。

例えば、「ChilloutMix」のようなリアル系モデルと、「Anything」のようなアニメ系モデルでは、出力される顔が全く異なります。さらに、同じリアル系でも「日本人の描画が得意なモデル」や「欧米人のフォトリアルが得意なモデル」など、種類は千差万別です。

Civitaiなどの配布サイトで、好みの顔立ちを出力しているモデルを探してダウンロードしてみるのがおすすめです。複数のモデルを使い分けることで、「同じ顔ばかり」という悩みから一気に解放されますよ。

Stable Diffusion 普通の顔を作るための工夫

「美少女ばかり生成されるけど、もっとStable Diffusionで普通の顔を出したい」というケースもありますよね。AIモデルは「美的に優れた画像」を学習しがちなので、放っておくと全員が絶世の美女になってしまいます。

もっと親しみやすい、普通の顔を出したい場合は、以下のようなプロンプトを試してみてください。

average look(平均的な見た目)light makeup(薄化粧)no makeup(すっぴん)imperfections(不完全さ・欠点)

逆に、美しすぎる顔を避けるために、ネガティブプロンプトにはあえて何も入れない、あるいは heavy makeup(厚化粧)などをネガティブに入れるといった調整も有効です。こうすることで、より人間味のある、自然な表情を引き出すことができます。

Stable Diffusionで「同じ顔ばかり」を脱却・制御する応用テクニック

ここまでは基本的な対策をお伝えしましたが、ここからはさらに一歩進んだテクニックを紹介します。

ツールや拡張機能を使いこなせば、ランダムに違う顔を出したり、逆に「顔だけ」をピンポイントで修正したりすることが可能になります。

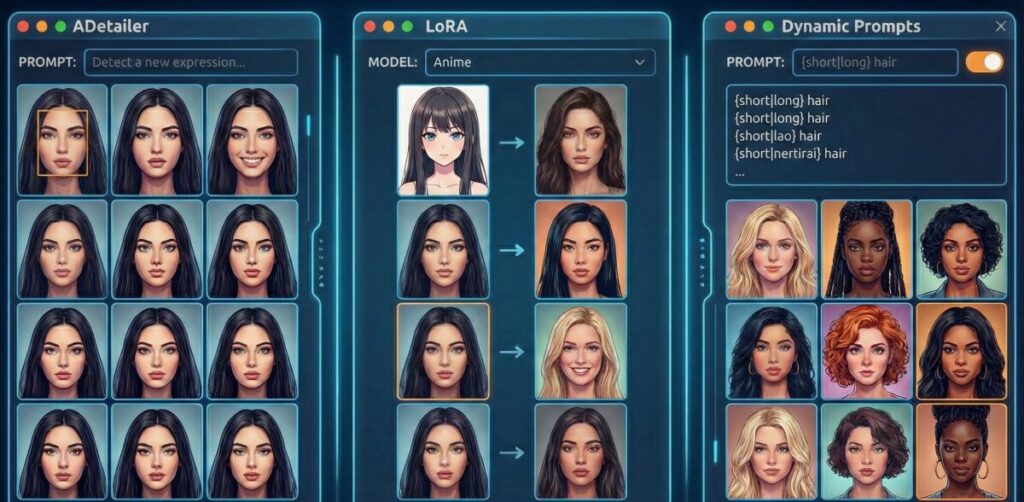

Dynamic Promptsで無限のバリエーションを作る

「いちいちプロンプトを書き換えるのは面倒くさい!」

そう思う方におすすめなのが、拡張機能の「Dynamic Prompts(Wildcards)」です。

これを使うと、プロンプトの一部をランダムに入れ替えることができます。

例えば、{short|long|bob} hair と記述しておけば、生成するたびに「ショートヘア」「ロングヘア」「ボブ」の中からAIが勝手に選んで描画してくれます。

髪型だけでなく、目の色、服装、表情などをこの形式で記述しておけば、ボタンを一度押して放置するだけで、Stable Diffusionで同じ画像ばかりになることなく、数百枚ものバリエーション豊かな画像を自動生成できるのです。これはガチャ感覚で新しい顔に出会えるので、非常に楽しいですよ。

Stable diffusion 同じ 顔 loraを使って画風を変える

Stable diffusionで同じ顔が出るならLoraを活用するのも一つの手です。

LoRA(Low-Rank Adaptation)とは、特定のキャラクターや画風、シチュエーションなどを追加学習させた「追加パーツ」のようなものです。

通常、特定のキャラを出すために使われることが多いLoRAですが、実は「画風を変えるLoRA」や「顔立ちを調整するLoRA」も多数存在します。

例えば、「韓国風の顔にするLoRA」や「彫りの深い顔にするLoRA」などを適用すれば、ベースのモデルを変えずに顔の雰囲気だけをガラッと変えることができます。

ただし、注意点もあります。LoRAを強く効かせすぎると(数値を1.0以上にしたりすると)、画質が崩れたり、逆にそのLoRAの学習元の顔に固定されすぎてしまったりすることがあります。適用強度は0.5〜0.8くらいに抑えて使うのが、自然な違う顔を作るコツです。

Stable Diffusion 顔 のみ修正するADetailerの活用

「全身の構図は完璧なんだけど、顔だけが崩れてる…」

「顔だけ別の表情に変えたい」

そんな時に最強のツールが「ADetailer」です。これは生成プロセスの最後に、Stable Diffusionで顔のみを検出し、高解像度で描き直してくれる拡張機能です。

ADetailerを使えば、遠景で顔がグチャグチャに潰れてしまった画像でも、顔だけをキラキラに修正してくれます。さらに、ADetailer内のプロンプト入力欄に smile や angry と入力すれば、元の画像のポーズはそのままに、表情だけを変更することも可能です。

これを使えば、「同じ顔ばかり」という悩みどころか、「この画像の顔だけを理想通りにしたい!」という高度な要望まで叶えられます。

Ai 同じ顔 なぜ?を解決して仕事に繋げる

ここまで紹介したテクニックを駆使すれば、趣味で楽しむ分には十分なクオリティが出せるはずです。ただ、もしあなたが「AIイラストを仕事にしたい」「副業で稼ぎたい」と考えているなら、もう一歩踏み込んだスキルが必要になるかもしれません。

実は、クライアントワークでは「ランダムに違う顔が出ること」よりも、「クライアントが求めた特定の顔を、どんな構図でも崩さずに維持すること」や「指先まで完璧にコントロールすること」が求められます。

独学でここまで習得するのは、エラーとの戦いでかなり時間がかかります。

私であれば、効率よくプロレベルのスキルを身につけるために、専門のスクールを活用することも検討します。

その中の一つに、「バイテック生成AIスクール」というスクールがあります。

ここは単なる使い方の講座ではなく、「実務活用」と「収益化」に特化しているのが特徴です。Stable Diffusionだけでなく、ChatGPTなども組み合わせた業務効率化や、ControlNetを駆使した商業レベルの画像生成を学べます。

特に、未経験からでも「LP制作」や「広告バナー」などの案件獲得までサポートしてくれるので、「AIスキルでお金を稼ぎたい」という人には、独学で迷走する時間をショートカットできる最適な環境かもしれません。興味があれば、一度チェックしてみると良いでしょう。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion まとめ

今回は、Stable Diffusionで同じ顔ばかり出てしまう原因と、その解決策について詳しく解説しました。

最後に、この記事のポイントをまとめます。

- AIは指定がないと学習データの平均的な顔を出力する性質がある

- シード値(Seed)が固定されていると同じ画像しか出ないため、-1に設定する

- プロンプトで髪型・目の色・国籍などを具体的に指定すると顔が変わる

- モデル(Checkpoint)によって得意な顔の傾向が全く異なる

- モデルを変更するのが一番手っ取り早く違う顔を出す方法である

- 平均的な顔を出したい時は「average look」などのプロンプトが有効

- Dynamic Promptsを使えば、自動でプロンプトをランダム化できる

- LoRAは特定の画風や特徴を加えるのに役立つが、効かせすぎに注意する

- ADetailerを使えば、顔だけを検出して高画質に修正・変更できる

- ADetailerは表情差分を作るのにも非常に便利なツールである

- ビジネスでは逆に「顔を固定する」スキルが求められることも多い

- ControlNetなどの高度な制御技術は実務レベルで必須となる

- 独学が難しい場合はバイテック生成AIスクールなどの専門スクールが近道である

- ネガティブプロンプトの調整も顔のバリエーションに影響を与える

- まずはSeed値の確認とプロンプトの追加から試してみるのが良い

参考資料・出典

この記事は、以下の公的機関および専門機関の一次情報を元に作成・確認を行っています。

- 総務省『令和6年版 情報通信白書:生成AIの急速な進化と普及』 https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd131210.html

※生成AIの技術的背景、市場動向、および利用における課題について参照 - 文化庁『AIと著作権(令和6年度著作権セミナー資料)』 https://www.bunka.go.jp/seisaku/chosakuken/94101501.html

※AI生成物の利用における著作権の考え方、権利侵害の判断基準について参照 - IPA(独立行政法人情報処理推進機構)『デジタルスキル標準(DSS)ver.1.2』 https://www.ipa.go.jp/jinzai/skill-standard/dss/about.html

※生成AI活用スキルの定義および、DX推進人材に求められる技術基準について参照

.jpg)