「自分のパソコンで、AIを使って自由に動画を作ってみたい!」

そう思ったことはありませんか?

画像生成AIとして有名なStable Diffusionですが、実は動画生成(Video to VideoやImage to Video)も、驚くほど進化しているんです。

特に注目されているのが、Stable Video Diffusion(SVD)という技術。

これをローカル環境、つまり自分のPCに入れることで、生成枚数や課金を気にせず、思う存分クリエイティブな実験ができるようになります。

「難しそう……」と不安になる必要はありません。

今回は、初心者の方でも迷わず導入できるように、WebUI(AUTOMATIC1111)を使った方法を中心に、優しく解説していきますね。

一緒に、静止画が動き出す魔法のような体験を楽しみましょう!

この記事を読むと、以下の点について理解が深まります。

- Stable Video Diffusionをローカル環境(AUTOMATIC1111)に導入する具体的な手順

- アニメ調や実写など、目的に合わせた動画生成のコツと使い方の基本

- 動画生成でよくある「映像のチラつき(一貫性のなさ)」を抑えるテクニック

- 生成AIスキルを実務レベルに高めるための学習の方向性

Stable Diffusion動画をローカル環境で導入する

まずは、動画生成を始めるための土台作りから始めましょう。

「ローカル環境」と聞くと少しハードルが高く感じるかもしれませんが、要は「自分のパソコンの中にAIの脳みそをインストールする」というイメージです。

クラウドサービスとは違い、一度環境を作ってしまえば、インターネットの向こう側のサーバー代を気にすることなく、好きなだけ試行錯誤できるのが最大のメリットですよ。

Stable Video Diffusionとは

Stable Video Diffusion(SVD)とは、画像生成AI「Stable Diffusion」の開発元であるStability AI社が公開した、動画生成用のAIモデルのことです。

これを簡単に言うと、「1枚の画像(静止画)を渡すと、そこから数秒間の動画を作り出してくれるAI」です。

これまでも動画生成AIはありましたが、SVDの凄さはその品質と滑らかさにあります。

実際に使ってみると分かりますが、背景の水の動きや、人物のちょっとした仕草などが、かなり自然に動くんですよ。

基本的に「Image to Video(画像から動画へ)」という仕組みを使っているので、まずは元となる最高の一枚を用意することが、成功への近道になります。

Stable Video Diffusion ローカル 導入

それでは、実際に導入の準備をしていきましょう。

ローカルで動かすためには、ある程度のパソコンのスペックが必要です。

動画生成は画像生成よりもさらにパワーを使うため、グラフィックボード(GPU)の性能がカギを握ります。

推奨スペック目安

| パーツ | 推奨スペック | 備考 |

| GPU | NVIDIA GeForce RTX 3060以上 | VRAM(ビデオメモリ)は10GB以上推奨 |

| メモリ | 16GB以上 | 32GBあると安心 |

| ストレージ | SSD | HDDだと読み込みが遅くなります |

もし、スペックが足りているか不安な場合は、タスクマネージャーで確認してみてくださいね。

VRAMが8GB程度でも動くことは動きますが、エラーが出たり生成に時間がかかったりすることがあります。

何はともあれ、まずは挑戦してみることが大切です。

Stable Video Diffusion AUTOMATIC1111

Stable Diffusionをローカルで動かすためのツールとして、最も普及しているのが「AUTOMATIC1111(WebUI)」です。

普段から画像生成でこれを使っている方も多いのではないでしょうか。

実は、このAUTOMATIC1111に「拡張機能」を追加するだけで、SVDが使えるようになるんです。

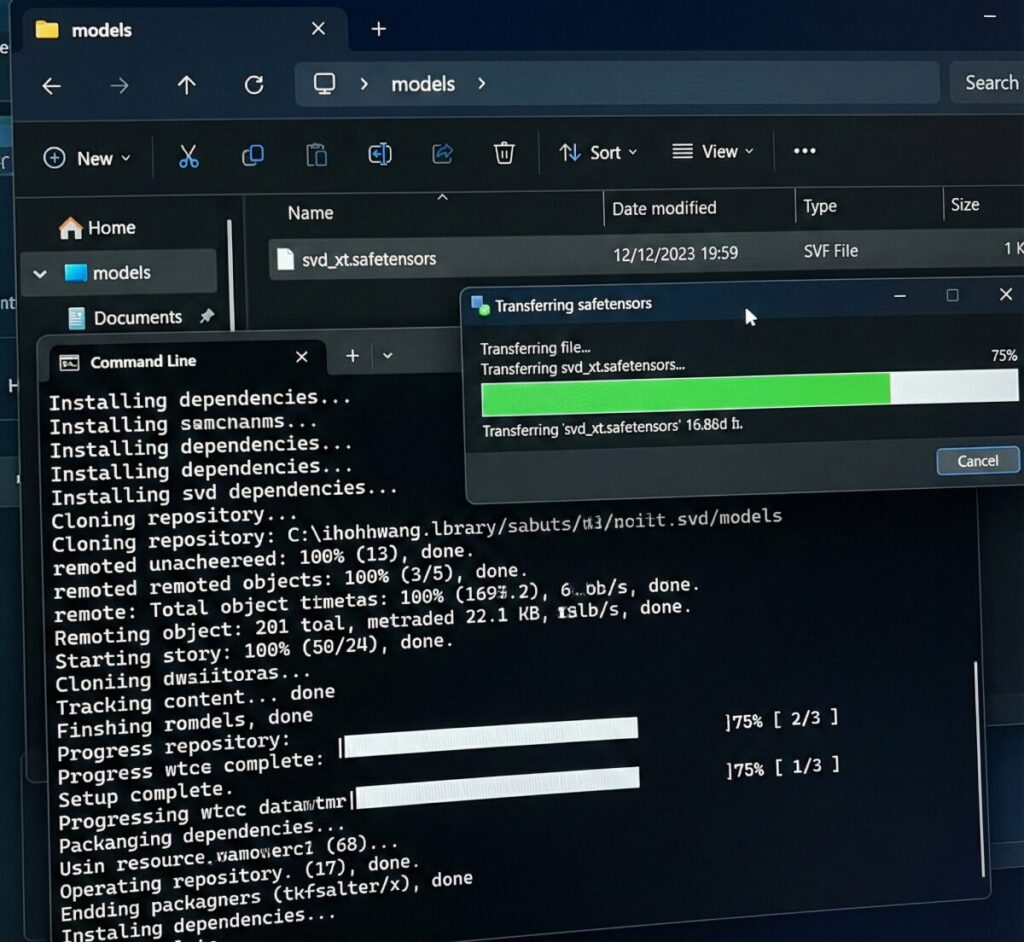

導入の基本ステップ

- AUTOMATIC1111の「Extensions」タブを開く

- 「Install from URL」にSVD用の拡張機能URLを入力してインストール

- WebUIを再起動する

- Stability AIの公式サイトから「SVDモデル(.safetensorsファイル)」をダウンロード

- 所定のフォルダ(models/svdなど)にモデルを入れる

たったこれだけで、いつもの画面に動画生成用のタブが出現します。

「黒い画面にコードを打ち込む」といった難しい操作はほとんど必要ないので、安心してくださいね。

Stable Diffusion 動画 アニメ化

「実写じゃなくて、アニメのような動画を作りたい!」という方も多いはずです。

SVD自体は、どちらかというとリアルな動きや3D的な表現が得意なのですが、元となる画像(ソース画像)をアニメ調にすることで、アニメーションのような動画も生成可能です。

ただ、ここで一つポイントがあります。

SVDは「リアルな物理法則」を学習している傾向があるため、アニメ特有の「パキッとした動き」や「デフォルメされた表現」を出すには、少しコツが要ります。

例えば、元画像を作る際に「anime style, flat color」などのプロンプトでしっかりと画風を固めておくことが重要です。

そうすることで、AIが「これはアニメなんだな」と認識しやすくなり、違和感の少ない動画が出来上がりますよ。

Stable Diffusion動画をローカルで高品質に作る

環境が整ったら、次はいよいよ実践編です。

ただ単にボタンを押すだけでも動画は作れますが、「もっと綺麗に」「もっとイメージ通りに」動かすためには、いくつかのパラメータ(設定値)を理解しておく必要があります。

ここでは、初心者がつまずきやすいポイントを押さえつつ、クオリティアップの秘訣をお伝えします。

Stable Video Diffusion 使い方

AUTOMATIC1111に導入したSVD拡張機能の使い方は、意外とシンプルです。

基本的には「元画像をアップロード」→「Generateボタンを押す」という流れになります。

しかし、画面には見慣れない数字が並んでいるかもしれません。

特に重要なのが以下の2つです。

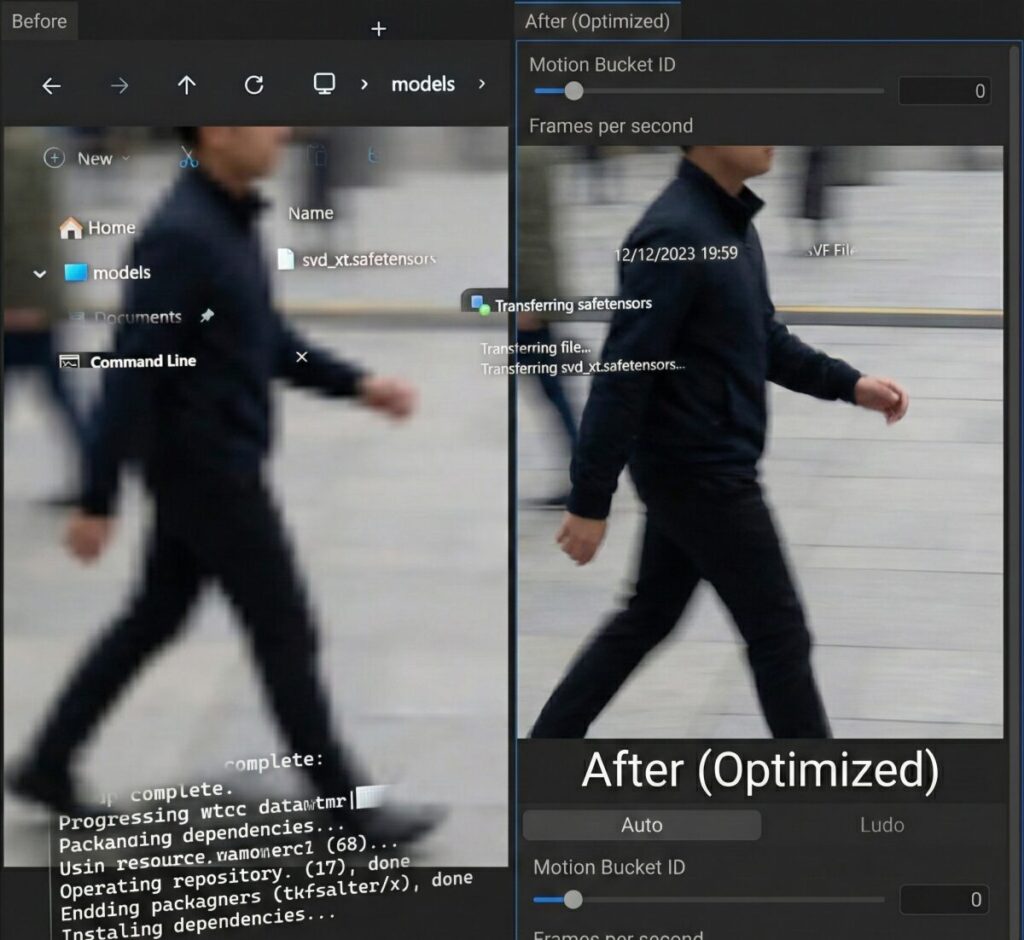

- Motion Bucket ID(モーションバケット)

- 動画の「動きの激しさ」を決めます。数字が大きいほど動きが大きくなりますが、大きすぎると映像が破綻しやすくなります。最初はデフォルト(127程度)で試して、動きが足りなければ上げてみましょう。

- Frames per second (fps)

- 1秒間に何枚の絵を表示するかです。6〜10fpsくらいが一般的です。

このとき、最初は小さなサイズ(512×512や1024×576など)でテスト生成するのがおすすめです。

いきなり高解像度でやると、生成に何分も待たされた挙句、失敗作が出てきた時のダメージが大きいからです。

まずは低解像度で動きを確認し、気に入ったら高解像度で本番生成、というフローが良いでしょう。

Stable Diffusion 動画 一貫性

動画生成における最大の敵、それは「一貫性のなさ(チラつき)」です。

フレームごとにキャラクターの顔が変わってしまったり、背景が勝手に変形したり……これでは見ていて疲れてしまいますよね。

これを防ぐためには、「Seed(シード値)」の固定が有効です。

一度良い動きが出たシード値を固定し、そこから少しずつ設定を微調整していくと、変化をコントロールしやすくなります。

また、「Augmentation Level」という数値を下げることで、元画像からの変化を抑えることも可能です。

元画像の形をどれだけ維持するか、というパラメータなので、これを低めに設定すると、顔が崩れにくくなります。

Stable Diffusion 動画 LoRA

「特定のキャラクターを動かしたい」

そんな時に役立つのがLoRA(追加学習モデル)です。

実は、SVDによる動画生成の工程そのものにLoRAを適用するというよりは、「元画像を作る段階」でLoRAをフル活用するのが正解です。

SVDはあくまで「与えられた画像を動かす」機能に特化しています。

そのため、最初の1枚を作る時点で、LoRAを使ってキャラクターのデザインや衣装、画風を完璧に作り込んでおきましょう。

もし、動画生成プロセス自体に作用する「AnimateDiff」などを使う場合は、動き専用のLoRA(Motion LoRA)を使うことで、カメラワーク(ズームイン、パンなど)を指定することもできます。

自分のやりたい表現に合わせて、適切なツールを選び分けるのが上級者への第一歩ですね。

確実なスキルを身につけるために

ここまで解説してきましたが、動画生成AIの世界は日進月歩で、新しい技術が次々と出てきます。

独学でエラーに対処しながら進めるのも楽しいですが、もしあなたが、

「この技術を使って、将来的に仕事を受けたい」

「フリーランスとして、企業から動画制作の案件を獲得したい」

と考えているなら、プロから体系的に学ぶのも一つの近道です。

例えば、「バイテック生成AIスクール」のような、実務活用に特化したスクールがあります。

ここは単なる趣味で終わらせるのではなく、「収益化」や「案件獲得」をゴールに置いているのが特徴です。

Stable Diffusionの複雑なコントロール技術や、実務で求められる高品質なアウトプットの作り方を、最短ルートで学べるカリキュラムが組まれています。

ポートフォリオの作成支援や営業文の添削までしてくれるので、未経験からプロを目指す方には心強い味方になるはずですよ。

一度チェックしてみるのも良いかもしれませんね。

AIを使って副業を始めたいけれど、「独学だと挫折しそう」「本当に案件が取れるか不安」という方は、実務と収益化に特化したスクールを検討してみるのも近道です。

\ ※完全オンライン・スマホで1分で予約完了 /

実際に、未経験から月5万円の収益化を目指せるバイテック生成AIというスクールについて、評判やカリキュラムの実態を詳しく検証してみました。

▼続きはこちらの記事で解説しています

Stable Diffusion動画ローカル生成のまとめ

今回は、Stable Diffusionを使ったローカル環境での動画生成について解説してきました。

最後に、要点をまとめて振り返りましょう。

これを読めば、今日からあなたも動画クリエイターの一歩を踏み出せるはずです。

- Stable Video Diffusion(SVD)は画像を動画にするAIモデルである

- ローカル環境なら生成枚数や課金を気にせず試行錯誤できる

- 導入にはVRAM 10GB以上のGPU推奨だが8GBでも動作は可能

- AUTOMATIC1111(WebUI)の拡張機能を使うのが手軽で一般的

- 拡張機能は「Install from URL」から簡単に導入できる

- SVDモデル(safetensors)を公式サイトからダウンロードして配置する

- アニメ調の動画を作るなら元画像をアニメ画風でしっかり生成する

- SVDは物理法則を重視するためデフォルメ表現には工夫が必要

- 使い方は「画像をアップロード」して「Generate」が基本

- 動きの大きさは「Motion Bucket ID」で調整する

- 動画のチラつき(一貫性)対策にはシード値の固定が有効

- Augmentation Levelを下げると元画像の崩れを防止できる

- キャラクター固定には元画像生成段階でのLoRA活用が重要

- AnimateDiffなどを併用するとカメラワークも指定可能になる

- 実務レベルを目指すなら専門スクールでの学習も近道である

参考資料・引用元

この記事の執筆にあたり、以下の開発元公式情報、論文、および公的機関の情報を参照しています。

- Stability AI:Stable Video Diffusion 公式発表

- (出典:Stability AI社 公式ニュースリリース)

- 解説:開発元であるStability AI社による、Stable Video Diffusion(SVD)のモデル公開、機能詳細、および商用利用に関する公式情報です。

- Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets (arXiv)

- (出典:コーネル大学図書館 arXiv.org)

- 解説:Stable Video Diffusionのアーキテクチャ、学習データセット、および動画生成の技術的仕組みについて詳細に記述された一次論文です。

- 文化庁:AIと著作権について

- (出典:文化庁 著作権課)

- 解説:日本国内において生成AIを利用してコンテンツを作成する際の、著作権の考え方や法的な留意点がまとめられた公的ガイドラインです。

.jpg)