- 「会議の議事録、誰が何を言ったか聞き分けるのが本当に大変……」

- 「文字起こしツールを使ってみたけど、話者が混ざって結局手直しに時間がかかる」

そんな悩み、抱えていませんか?

実は、AI音声認識モデル「Whisper」と、話者分離技術「Pyannote」を組み合わせることで、その悩みは劇的に解消できるんです。これまではプログラミングの深い知識がないと難しかった高度な文字起こしが、今では個人でも手の届くレベルになってきています。

私自身も最初は「難しそう」と敬遠していましたが、実際に使ってみると、その精度の高さに驚きました。もう手作業でのタグ付けには戻れません。この記事では、初心者の方でも分かるように、Whisperを使った話者分離の仕組みから、具体的な実装方法まで、優しく噛み砕いて解説していきます。

この記事を読むと以下のことが分かります

- WhisperとPyannoteを組み合わせて「誰が話したか」を識別する仕組み

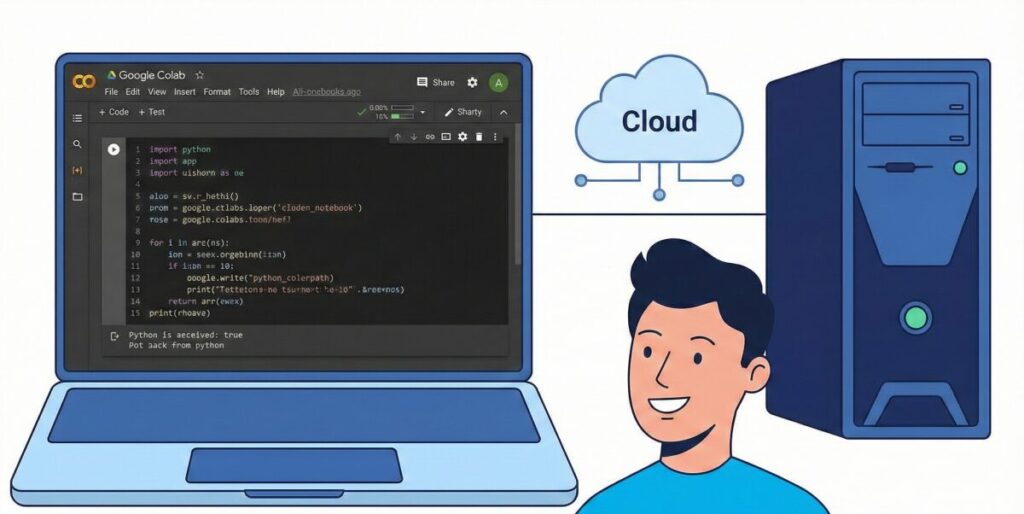

- Google Colabを使って無料で環境を構築する方法とメリット

- ローカル環境とクラウド環境、それぞれの精度の違いと選び方

- リアルタイム処理の現状と、文字起こしを仕事にするための第一歩

Whisperで話者分離を実現する仕組みと精度

「Whisper」という名前は聞いたことがあっても、「話者分離(ダイアライゼーション)」までできるの?と疑問に思う方は多いはずです。

結論から言うと、Whisper単体では「誰が話しているか」までは分かりません。そこで登場するのが、強力なパートナーである「Pyannote」です。ここでは、この2つがどう連携して、魔法のような文字起こしを実現しているのかを解説します。

Whisperと話者識別の関係性

まず、基本的な役割分担を理解しておきましょう。WhisperはOpenAIが開発した「耳のいいAI」です。音声データを聞いて、それを非常に高い精度でテキストにする能力はずば抜けています。しかし、Whisperには「今の声はAさん、さっきの声はBさん」と聞き分ける能力が標準では備わっていません。

そこで、話者識別(Speaker Diarization)専門のAIである「Pyannote」を組み合わせます。イメージとしては、Whisperが言葉を書き取り、Pyannoteがその横で「これは佐藤さん」「これは鈴木さん」と名札を貼っていくような作業を全自動で行うのです。

この「最強のタッグ」を組むことで、はじめて実用的な議事録作成が可能になります。これを理解しているだけで、ツールの選び方が大きく変わってきますよ。

Pyannoteを用いた話者分離のメリット

Pyannote Audioは、現在オープンソースで利用できる話者分離モデルの中でトップクラスの性能を誇ります。

何がすごいかと言うと、事前に「話者の人数」を指定しなくても、AIが勝手に「今回は3人で話しているな」と推測して分離してくれる点です(もちろん、指定した方が精度は上がります)。

また、Hugging Faceというプラットフォームを通じてモデルが公開されており、Pythonというプログラミング言語を使えば、誰でも無料で利用できるのが最大のメリットでしょう。高額な議事録作成ツールを契約しなくても、自分で仕組みを作れてしまうのです。「自分だけの文字起こしツール」を持てるなんて、ワクワクしませんか?

Pyannoteによる話者分離の精度と限界

「でも、本当に仕事で使えるレベルなの?」と心配になる方もいるでしょう。

私の経験では、Pyannoteの話者分離精度はかなり高いです。特に、静かな会議室で、一人ひとりがはっきりと話しているような音声データであれば、ほぼ完璧に分離してくれます。

ただ、苦手なシチュエーションもあります。

例えば、居酒屋のようなガヤガヤした場所や、複数人が同時に喋って声が重なっている場面(オーバーラップ)です。こうなると、さすがのAIも「どっちが喋っているか」を迷ってしまい、話者のタグ付けが入れ替わってしまうことがあります。

精度の目安

| シチュエーション | 精度 | 備考 |

|---|---|---|

| オンライン会議(1人ずつ発言) | ◎ | ほぼ修正不要 |

| 対面会議(静かな部屋) | 〇 | 多少の手直しでOK |

| 雑談・相槌が多い会話 | △ | 短い相槌を誤認識しやすい |

| 騒音・複数人の同時発話 | × | 手動修正が必須 |

このように、完璧ではないものの、ゼロから手作業する労力に比べれば、作業時間は3分の1以下に短縮されます。

話者分離付き文字起こしのフロー

では、実際にどういう流れでデータが出来上がるのか、イメージしてみましょう。

- 音声データの読み込み: 録音したデータをAIに渡します。

- Pyannoteによる分析: まず音声の波形を見て「ここからここまでが話者A」「ここからは話者B」とタイムスタンプを記録します。

- Whisperによる文字起こし: 音声全体、または区切られた区間ごとにテキスト化を行います。

- 統合(マージ): Pyannoteの時間情報と、Whisperのテキスト情報を合体させます。

最終的には、「[00:00 – 00:15] 話者A: おはようございます。本日の議題ですが……」といった形式で出力されます。この工程を自動化するスクリプト(プログラム)を組むのが、今回のゴールのひとつです。

Whisperで話者分離を実践する具体的な方法

仕組みが分かったところで、次は「どうやって使うか」という具体的な方法論に入っていきましょう。

「プログラミングなんてやったことない」という方でも大丈夫です。今はブラウザだけで完結する方法もありますし、本格的にやりたい人向けのローカル構築もあります。ご自身の環境や目的に合わせて選んでみてください。

Whisperの話者分離ならColabがおすすめ

初心者の方に一番おすすめしたいのが、「Google Colab(コラボ)」を使う方法です。

Google Colabは、Googleが提供している「ブラウザ上でPythonコードを実行できるサービス」です。これの何が素晴らしいかというと、高性能なGPU(画像処理装置)を無料で使えるという点です。

WhisperやPyannoteのようなAIモデルを動かすには、パソコンに高い処理能力(特にGPU)が求められます。一般的なノートパソコンでは、1時間の音声を処理するのに数時間かかってしまうことも珍しくありません。

しかし、Colabを使えば、Googleの強力なコンピューターを借りて処理できるため、サクサク動きます。ネット上には、有志が公開してくれている「コピペで動くノートブック(コードのまとまり)」がたくさんあります。まずは「Whisper Pyannote Colab」で検索して、コードを実行してみるのが一番の近道です。初期費用ゼロで始められるので、リスクがありません。

話者分離をローカル環境で構築する場合

「機密情報を扱うから、クラウドに音声をアップロードしたくない」

「ネット環境がない場所でも作業したい」

そんなプロフェッショナルな方には、自分のPC(ローカル環境)にシステムを構築することをおすすめします。

ただし、これには条件があります。NVIDIA製の高性能なGPU(GeForce RTX 3060以上推奨)を搭載したデスクトップPCやゲーミングノートPCが必要です。

ローカル環境構築のメリットは、完全なプライバシー保護と、制限時間のない処理です。Colabの無料版には使用時間の制限がありますが、自分のPCなら24時間回しっぱなしでも問題ありません。大量の過去音声をアーカイブ化したい場合などは、思い切って専用PCを用意し、Dockerなどを使って環境構築をする価値は十分にあります。ここができれば、AIエンジニアとしてのスキルも一気に身につきますよ。

Whisper APIでは話者分離はできない?

ここで注意点があります。「OpenAIの公式API(Whisper API)を使えば簡単なんじゃない?」と思うかもしれません。

しかし、現時点ではWhisperの公式APIには話者分離機能(Diarization)が含まれていません。APIが返してくれるのは、あくまで「文字起こしされたテキスト」だけです。

もしAPIベースで話者分離まで行いたい場合は、Whisperそのものではなく、Whisperを組み込んだサードパーティのAPIサービス(例:Gladiaなど)を利用するか、自分でWhisperとPyannoteを動かすサーバーを立てる必要があります。

「APIなら何でもできる」と思い込んで開発を始めると、後で「話者分けができない!」と躓くことになるので、この仕様はしっかり覚えておいてくださいね。

Whisperによる話者分離リアルタイム処理の壁

最後に、誰もが憧れる「リアルタイム文字起こし&話者分離」についてです。

「会議中に、リアルタイムで誰が喋っているか画面に表示したい!」と思いますよね。

正直なところ、WhisperとPyannoteの組み合わせでの完全リアルタイム処理は、まだハードルが高いのが現状です。

精度を出すためには、ある程度の長さの音声データをまとめて分析する必要があるため、どうしても数秒~数十秒のラグ(遅延)が発生します。「今喋っている内容が、瞬時に話者名付きで出る」というレベルを求めるなら、ZoomやTeamsの有料プランに付いている標準機能を使った方が、現時点では快適かもしれません。

ただ、技術の進歩は早いです。軽量化されたモデルや、ストリーミング処理に特化した技術も出てきています。「今はまだ難しいけれど、近い将来できるようになる」分野として、アンテナを張っておくと良いでしょう。

Whisperの話者分離まとめ

AI技術は「知っているか知らないか」だけで、業務効率に天と地ほどの差が出ます。

今回のWhisperとPyannoteの組み合わせは、まさにその典型です。最初はGoogle Colabでコードを触ってみるだけでも、「自分にもできた!」という大きな自信になるはずです。そこから、より高度なPythonプログラミングを学んで自分好みにカスタマイズするのも良いですし、便利なツールとして使い倒すのも自由です。

ぜひ、この機会に新しいスキルへの一歩を踏み出してみてください。

この記事の要点まとめ

- Whisper単体では話者の識別はできず、文字起こしのみを行う

- Pyannote Audioを組み合わせることで、高精度な話者分離が可能になる

- Pyannoteは話者数を自動推定できるが、指定すると精度が向上する

- 静かな会議室での会話は得意だが、重なった声や騒音は苦手である

- WhisperとPyannoteの統合にはPythonなどのプログラミング知識が役立つ

- 初心者はGoogle Colabを使うことで、GPU環境を無料で利用できる

- 一般的なノートPCでは処理が重いため、ColabかハイスペックPCが推奨される

- ローカル環境での構築にはNVIDIA製GPU(RTXシリーズなど)が必要である

- ローカル環境はセキュリティ面で安心であり、機密情報の扱いに適している

- OpenAIの公式Whisper APIには、現時点で話者分離機能は搭載されていない

- APIを利用したい場合は、サードパーティ製のサービスを検討する必要がある

- リアルタイムでの話者分離は技術的に難しく、遅延が発生しやすい

- まずはColabにある既存のノートブックを試すのが一番の近道である

- Pythonを学ぶことで、出力形式や精度調整を自由にカスタマイズできる

- AIによる自動化は、議事録作成の時間を大幅に短縮する強力な武器になる

信頼できる参考文献・一次情報源

本記事の技術的根拠および使用モデルの詳細は、以下の公式情報・学術論文に基づいています。

- Introducing Whisper | OpenAI Research

- (出典:OpenAI 公式サイト)

- 音声認識モデル「Whisper」のアーキテクチャ、学習データセット、および英語・多言語における認識精度に関する公式の研究発表です。

- pyannote.audio: neural building blocks for speaker diarization | arXiv

- (出典:Cornell University – arXiv.org)

- 話者分離(Speaker Diarization)のデファクトスタンダードである「pyannote.audio」のアルゴリズムと技術的背景を詳説した学術論文です。

- pyannote/speaker-diarization-3.1 | Hugging Face

- (出典:Hugging Face 公式モデルカード)

- 本記事で解説した最新の話者分離パイプラインの実装仕様、ベンチマークスコア、および使用許諾条件が記載された公式ドキュメントです。

.jpg)