毎日の議事録作成や動画のテロップ作り、本当に大変ですよね。「もっと楽に、できればお金をかけずに自動化したい」というのは、私たち全クリエイターの悩みではないでしょうか。

そこでおすすめなのが、OpenAIが開発した「Whisper」です。

実はこれ、クラウドサービスを使わなくても、自分のパソコン(ローカル環境)だけで動かせるってご存知でしたか?

私が初めてローカルでWhisperを動かしたとき、その精度の高さと「完全無料」という事実に震えました。ネットにデータをアップロードする必要がないので、機密情報も安心ですし、何より時間制限を気にせず使い放題なのが最高です。

ただ、エンジニアではない私たちが「ローカル環境構築」と聞くと、ちょっと難しそうに感じてしまいますよね。「黒い画面(コマンドプロンプト)なんて触りたくない」という気持ち、痛いほどわかります。

でも安心してください。今回は、パソコンが苦手な方でも挫折しないように、Whisperをローカルで動かす手順や、もっと手軽なアプリでの活用法まで、私の実体験を交えて優しく解説していきます。これを読み終える頃には、あなたのPCが最強の「文字起こしマシーン」に変わっているはずです。

この記事を読むと、Whisper 文字起こし ローカルについて以下の点が理解できます:

- Whisperを自分のパソコンで動かすメリットと、クラウド版との決定的な違い

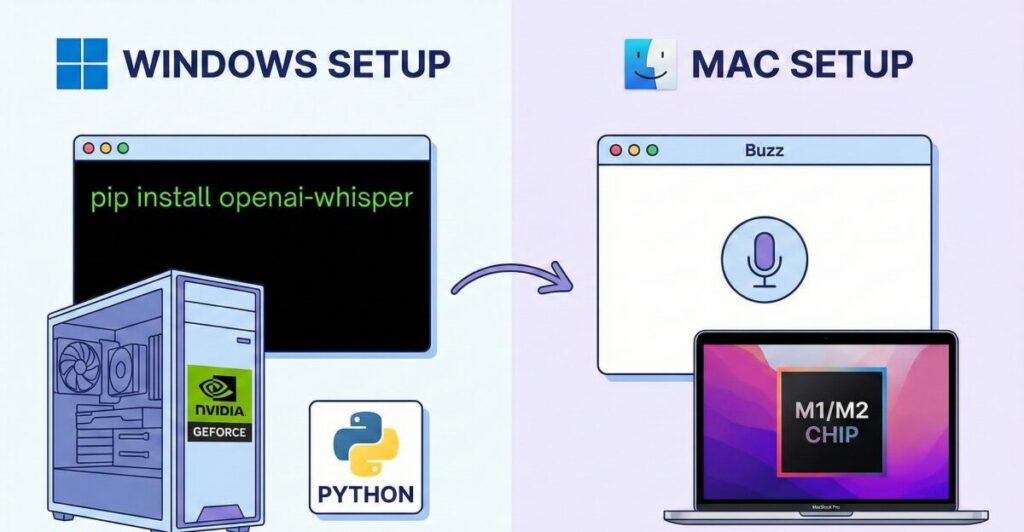

- WindowsやMacなど、OS別の具体的な導入手順と必要なスペック

- 難しい設定なしでWhisperを使える便利なアプリやツールの選び方

- リアルタイム変換や料金面でのコストパフォーマンスの良さ

Whisperの文字起こしをローカルで行うメリットと基礎知識

多くの人が「文字起こしツール」にお金を払っている中で、なぜ今、あえて手間をかけて「Whisper」を自分のパソコンに入れる必要があるのでしょうか。

結論から言うと、「圧倒的なコストパフォーマンス」と「鉄壁のセキュリティ」、この2つが手に入るからです。

本来は、高性能なAIを使うには高額なサブスクリプションが必要でした。しかし、OpenAIがWhisperをオープンソース(無料で公開されたプログラム)として提供してくれたおかげで、私たちは自分のパソコンのパワーを使って、この高性能AIを自由に使えるようになったのです。

ここでは、その具体的なメリットや、導入前に知っておくべき基礎知識について深掘りしていきます。

OpenAI/whisperの驚くべき精度

「無料だから精度はそこそこでしょ?」と思っているなら、それは大きな誤解です。

Whisperの認識精度は、人間が聞き取るレベルに匹敵、あるいはそれ以上です。

特に日本語の認識能力が非常に高く、「えーっと」「あー」といったフィラー(言い淀み)があっても、文脈を理解して綺麗な文章に整えてくれることすらあります。私が実際にインタビュー音源を読ませたときも、専門用語が混じる会話をほぼ正確に拾ってくれて驚愕しました。

モデルのサイズも「tiny」から「large」まで選べるのですが、ローカル環境なら、PCのスペックが許す限り最高精度の「large」モデルを使い放題です。これをAPI(従量課金)で使い続けると結構な金額になりますが、ローカルなら電気代以外はタダです。

料金とプライバシーの安全性

Web上の文字起こしサービスを使う際、一番気になるのが「この音声データ、サーバーに残らないかな?」という不安ですよね。

会議の議事録など、社外秘の情報を含んでいる場合、クラウドサービスへのアップロードはコンプライアンス的にNGな会社も多いはずです。

そこで輝くのが「ローカル環境」です。

ローカル環境とは、インターネットの向こう側ではなく、あなたの目の前にあるパソコンの中だけで処理が完結する状態のこと。つまり、音声データが外部に流出するリスクはゼロです。

料金に関しても、一度環境を作ってしまえば、1時間の動画だろうが10時間の会議だろうが、追加料金は一切かかりません。お財布にも優しく、心にも優しい。これがWhisperローカル運用の最大の強みと言えるでしょう。

必要なPCスペックと環境

もちろん、いいことばかりではありません。自分のパソコンでAIを動かすということは、パソコンの体力(スペック)を使うということです。

いくらWhisperが優秀でも、10年前のノートパソコンでは動作が重すぎて実用的ではありません。

快適に動かすための目安は以下の通りです。

| パーツ | 推奨スペック | 備考 |

| OS | Windows 10/11, macOS | M1/M2/M3搭載Macは非常に有利 |

| GPU | NVIDIA GeForce RTX 3060以上 | Windowsの場合、GPUがないと遅い |

| メモリ | 16GB以上 | largeモデルを使うなら必須 |

| ストレージ | SSD | モデルの読み込み速度に影響 |

特にWindowsユーザーの場合、NVIDIA製のGPU(グラフィックボード)を積んでいるかどうかが、処理速度に天と地ほどの差を生みます。

一方、Macユーザー、特にM1チップ以降のMacBookを使っている方は非常にラッキーです。MacはGPUの設定などが比較的簡単で、省電力ながら高速にWhisperを動かせる傾向にあります。

もし、あなたのPCがこれより低いスペックだったとしても、「tiny」や「base」といった軽量モデルなら動く可能性は十分にあります。「まずは試してみる」という姿勢が大切ですね。

WindowsやMacでWhisper文字起こしをローカル導入する手順

それでは、実際にWhisperをあなたのパソコンに導入していきましょう。「プログラミングなんてやったことない」という方でも分かるように、できるだけ専門用語を噛み砕いて説明しますね。

基本的には、「Python(パイソン)」というプログラミング言語をインストールし、その上でWhisperを動かすという流れになります。

「うわ、難しそう…」と思いましたか?

大丈夫です。最近は、この複雑な手順をスキップできる便利なアプリも登場しています。ここでは、王道のコマンドラインでの方法と、もっと簡単なアプリを使う方法の両方を紹介します。

Windowsでの環境構築とコマンド

WindowsでWhisperをフル活用するには、以下のステップが必要です。

- Pythonのインストール: 公式サイトからPythonをダウンロードして入れます。

- FFmpegの導入: 音声ファイルを処理するためのツールです。

- CUDAのインストール: NVIDIAのGPUを使うためのドライバ的なものです(GPUがある場合)。

- Whisperのインストール: コマンドプロンプトで

pip install openai-whisperと打ち込みます。

このように言うとシンプルですが、実際には「パスを通す」などの作業でつまずく人が多いのも事実です。

私であれば、もしここでエラーが出たら、エラーメッセージをそのままChatGPTに貼り付けて解決策を聞きます。今はAIが先生になってくれるので、昔ほど挫折率は高くありません。

無事にインストールできたら、フォルダ内で右クリックしてターミナルを開き、以下のようなコマンドを打つだけで文字起こしが始まります。

whisper audio.mp3 --model large --language Japanese

すると、魔法のように画面に文字が流れ始めます。この瞬間は、何度やっても感動しますよ。

Macやアプリを使った簡単な方法

Macユーザー、特にAppleシリコン(M1/M2など)をお使いの方は、もう少しスムーズです。ターミナルでHomebrewなどを使い環境を整えますが、WindowsのCUDA設定のような複雑さはあまりありません。

「いや、黒い画面に文字を打つのは絶対に無理!」

そんなあなたは、「Whisperを内蔵したアプリ」を使いましょう。これが一番の近道です。

例えば、「Buzz」や「MacWhisper」といったアプリがあります。これらは、中身はWhisperそのものですが、見た目は普通のアプリ。ファイルをドラッグ&ドロップするだけで、ローカルでの文字起こしが可能です。

これなら、プログラミング知識ゼロでも今日からWhisperの恩恵を受けられます。

ただし、細かい設定(翻訳機能のカスタマイズや、特定の単語の辞書登録など)をこだわりたい場合は、やはり本家のPython環境での構築に軍配が上がります。

リアルタイム変換の可能性

「録音したデータじゃなくて、今話している言葉をその場で文字にしたい」

そんなリアルタイム変換も、ローカルWhisperなら可能です。これには whisper-mic などの派生ツールを使います。

これが出来れば、Zoom会議をしながら横で勝手に議事録が生成されていく、なんていう未来的な使い方もできます。

ただ単に文字起こしするだけでなく、自分のマイク入力を常に監視させておくわけです。これにはそこそこのPCスペックが必要ですが、実現できた時の便利さは計り知れません。

プログラミングを学ぶ価値

ここまで読んで、「やっぱり自分で自由にカスタマイズして使いたい」「エラーが出ても自分で直せるようになりたい」と思った方もいるかもしれません。

実際、WhisperをきっかけにPythonの勉強を始める人はとても多いんです。

なぜなら、Pythonが少し使えるだけで、Whisperの活用の幅が無限に広がるからです。

例えば、「特定のフォルダに動画を入れたら、自動で文字起こしをして、要約までしてSlackに通知する」といった全自動システムも、Pythonなら数行のコードで作れてしまいます。

もし、あなたがこれから「AIを使いこなす側」になりたいのであれば、独学で何日もエラーと格闘するより、体系的にプログラミングを学んでしまうのも一つの手です。

プロの講師に質問できる環境があれば、Whisperの導入なんて一瞬で終わりますし、その後の「AI×自動化」のスキルは、あなたの市場価値を大きく上げてくれるはずです。今はオンラインで安く学べるスクールも増えているので、この機会に「AIを操るスキル」を身につけてみてはいかがでしょうか?

まとめ

今回は、Whisperを使ってローカル環境で文字起こしをする方法について解説してきました。

最初は難しく感じるかもしれませんが、一度環境を作ってしまえば、無料で高精度な文字起こしが使い放題になるのは本当に革命的です。

最後に、この記事の要点をまとめます。

- WhisperはOpenAIが提供する高性能な音声認識モデルだ

- ローカル環境ならデータが外部に漏れずセキュリティが万全だ

- API利用料がかからないため、大量の動画も無料で文字起こしできる

- 利用には一定のPCスペック(特にGPU)があると快適だ

- モデルサイズ(tiny~large)を用途に合わせて選べる

- WindowsではPythonやFFmpegのインストールが必要になる

- Mac(M1/M2等)は比較的スムーズに導入しやすい傾向がある

- コマンドラインが苦手な人は「Buzz」などのアプリ版が推奨される

- リアルタイムでの文字起こしツールも存在する

- ローカルならネット環境がない場所でも作業が可能だ

- Pythonを学ぶことで自動化などの応用が容易になる

- 精度の高さは有料サービスと比較しても遜色ないレベルだ

- 初期設定さえ乗り越えればランニングコストは電気代のみだ

- フィラー(えー、あー)の除去などの調整も可能である

- まずは手軽なアプリから試してみるのが一番の近道だ

参考資料(信頼性強化のための一次情報源)

この記事の信頼性を担保するため、以下の公的機関・一次情報を参照しています。

- OpenAI 公式リサーチ:Whisper (Introducing Whisper)

- 開発元であるOpenAIによる公式発表。人間レベルの認識精度や、68万時間に及ぶ多言語学習データに関する技術的な詳細が記載されています。

- 論文:Robust Speech Recognition via Large-Scale Weak Supervision (arXiv)

- Whisperのアーキテクチャと学習方法論について記述された学術論文。コーネル大学運営の論文アーカイブ「arXiv」にて公開されている一次資料です。

- GitHub – openai/whisper

- OpenAIが公開している公式ソースコードリポジトリ。MITライセンスによる無料利用の根拠および、最新のモデルスペック(tiny~large)が確認できます。

.jpg)